Interprétation de la Musique mixte - transfert de technologie, authenticité et fidélité : étude de cas du développement de la version temps réel d’Inharmonique (1977) de Jean-Claude Risset

José Luis Ferreira septembre 2023Traduction de João Svidzinski

septembre 2023Traduction de João SvidzinskiDOI : https://dx.doi.org/10.56698/rfim.666

Résumés

Résumé

Cet article est la traduction révisée d’une partie de la thèse de José Luis Ferreira, qui présente le projet « Jean-Claude Risset’s Inharmonique : recast and a real time version proposal » en partenariat avec António de Sousa Dias. Les objectifs du projet étaient le transfert de technologie intégral avec sa documentation et la proposition d’une version en temps réel de cette œuvre. Il s’agit du rapport de la première ébauche du projet. Dans un premier temps, l’auteur introduit le concept de système de relations dynamiques et l’applique par la suite au portage de la pièce de Risset.

Abstract

This paper is an edited translation of an excerpt of José Luis Ferreira’s PhD thesis, presenting the project “Jean-Claude Risset’s Inharmonique: recast and a real time version proposal” in partnership with António de Sousa Dias. The objectives of the project were the full technology transfer and documentation and the proposition of a real time version of this work. This is the report of the first draft of the project. The author first introduces the concept of a system of dynamic relations and then applies it to the implementation of Risset’s composition.

Index

Index de mots-clés : temps réel, préservation, Jean-Claude Risset, Musique mixte, interprétation.Index by keyword : Mixed music, Jean-Claude Risset, real time, performance, preservation.

Texte intégral

Introduction à la version française

1Le développement de la nouvelle version interactive temps réel d’Inharmonique (1977) de Jean-Claude Risset a été commencé par le compositeur-chercheur José Luis Ferreira en partenariat avec António de Sousa Dias et avec la contribution du compositeur Jean-Claude Risset lui-même. Cet article posthume découle de la thèse de doctorat de Ferreira. Deux chapitres sont fusionnés dans cette version révisée et traduite en français. Dans la première partie de l’article, l’auteur introduit le concept de système de relations dynamiques [sistema de relações dinâmicas]. Il s’agit d’une notion assez personnelle qui englobe les relations entre les différents agents (interprète de l’électronique, compositeur, instrumentiste, etc.), ainsi que les relations homme-machine, au cœur de la pratique musicale, notamment la création et l’interprétation. Ensuite, ce concept sera appliqué dans le projet de création de la nouvelle version d’Inharmonique1.

2L’auteur part d’une réflexion sur le rôle de l’interprète dans la musique électroacoustique pour définir les enjeux de cette activité. Pour cela, il initie une réflexion qui oppose temps réel et temps différé. Ferreira a composé la pièce Metha (2010) pour basson et électronique temps réel. Ce paradigme a été choisi afin de mettre en lumière l’interaction entre l’instrument acoustique et électronique. En raison d’une limitation technique, et pour que la pièce soit plus facilement jouée, le compositeur a figé la partie électronique (Ferreira, 2011). Cet exemple est similaire au cas de la pièce Metallics (1995) de Yan Maresz, dont la partie électronique a été composée originalement en temps réel et ensuite, l’année même de la création, a été transformée en une nouvelle version en temps différé. Actuellement, les deux versions de cette pièce sont disponibles. Au-delà d’une discussion sur l’opposition entre temps réel et différé, l’auteur s’intéresse surtout au rôle de l’interprète du répertoire mixte. En effet, l’aspect technique est seulement la toile de fond d’une discussion riche autour de questions liées à l’interprétation et à la pratique de ce répertoire. Ainsi, cette discussion l’amène à considérer l’interprétation de la partie électronique elle-même, c’est-à-dire, des opérations à l’intérieur du code informatique, comme un patch Max par exemple. Le rôle de l’interprète électronique ne se résume pas à un « exécutant », un technicien, mais constitue un maillon très important dans le processus de création et de re-création d’une pièce mixte.

3Ainsi, Ferreira fait écho à des problématiques d’actualité comme la préservation de la partie électronique et le statut et fidélité de la partie électronique des pièces mixtes lors du processus de portage de versions. Ces points sont actuellement au cœur des projets de recherche. Notamment au sein du groupe de travail « Archivage collaboratif et préservation créative » (Lemouton et al., 2019) soutenu par l’Association Francophone d’Informatique Musicale (AFIM). Certes, tous ces points font partie de la routine d’un RIM - réalisateur en informatique musicale - professionnel responsable de la conception, l’interprétation et la préservation de ce répertoire. Cependant, Ferreira témoigne d’un contexte assez distant des grands centres de création musicale qui n’ont pas les moyens des grandes productions2. Dans le cas de Ferreira, le compositeur et l’interprète doivent faire preuve d’une grande polyvalence.

4Enfin, sa démarche met en évidence la figure du compositeur-analyste dans un travail de recherche-création. L’auteur part d’une activité de création qui a une influence directe sur son rôle d’interprète de musique mixte. Ce rôle est intimement lié à l’analyse du répertoire du passé. L’expérience que l’auteur a vécue lors du travail sur sa propre pièce Metha (2010) a été le point de départ de son travail d’interprète-analyste de la pièce de Risset.

5Finalement, l’auteur effleure des questions comme la notation dans la musique électroacoustique et l’importance de la documentation, avec des instructions d’exécution, pour assurer la pérennité de l’œuvre autour de ses reprises. La fin de l’article détaille le projet de re-création de la nouvelle version d’Inharmonique. Au moment de la première publication de ce texte, il se résumait à un prototype qui n’avait pas encore été testé. La suite et la consolidation de ce travail a eu lieu lors de la création de la nouvelle version temps réel interactive d’Inharmonique en 2019, presque dix ans après la publication originale de ce texte.

1 Vers un système de relations dynamiques

1.1 Interprétation de la partie électronique - le temps différé et le temps réel

6La musique mixte est un genre musical qui s’est établi depuis la seconde moitié du 20e siècle3. Elle peut être définie comme la jonction du milieu acoustique avec le milieu électroacoustique, plus précisément : la combinaison dans la performance4 d’un ou plusieurs instruments acoustiques avec des sons créés, traités ou reproduits électroniquement. Cela se passe au moment du concert. Ainsi, nous avons cherché à établir les différentes problématiques entourant les musiques mixtes de tradition écrite qui impliquent fondamentalement la création et la liberté performative (aussi bien de la partie acoustique que de la partie électronique), en deux facteurs majeurs : technologique et humain.

7Par rapport au facteur technologique, l’électronique dans la musique mixte peut se caractériser selon ses deux stratégies principales : le temps différé et le temps réel. Pour la première, l’électronique est fixe, immuable. Dans ce cas, le performer instrumentiste est accompagné de la diffusion de sons électroniques, créés au préalable par le compositeur. Pour le temps réel, l’électronique est générée ou manipulée au moment du concert. Même si la diffusion en temps différé demande une configuration technique moins complexe (par exemple, la diffusion d’un fichier de son) que celle du temps réel, à l’heure actuelle, les deux stratégies font appel à des ordinateurs et à des logiciels.

8Ainsi, d’après nos propres expériences, nous avons établi une typologie fondamentale concernant la performance de ce répertoire. Tout d’abord, la configuration de l’électronique, le choix de logiciel et de synthèse de son, ainsi que les méthodes compositionnelles propres, conditionnent le processus créatif ainsi que la performance elle-même. Or, les compositeurs doivent être conscients qu’il n’y a pas de système libre de contraintes et qu’il faut souvent chercher un compromis entre les inconvénients inhérents au système choisi afin de mieux servir leurs intentions.

9Ainsi, les deux stratégies, temps différé et temps réel, ont des avantages et des inconvénients. Le degré de liberté du performer électronique est proportionnel à la malléabilité de la configuration électronique. C’est-à-dire, si l’on considère un axe avec le temps différé à une extrémité et le temps réel à l’autre, par le biais de l’utilisation de systèmes hybrides, le degré de liberté de l’expressivité tend à augmenter progressivement en allant du temps différé au temps réel. Bien que, dans les systèmes en temps réel, nous constatons que la liberté de performance est plus grande que celle rendue possible par les stratégies qui n’utilisent que le temps différé, il peut aussi y avoir des contraintes. Celles-ci peuvent être attribuées à l’utilisation de la technologie, notamment à la manière dont elle peut affecter l’expression performative. Ainsi, nous avons constaté l’existence d’un engagement technologique qui peut être en conflit avec l’engagement d’expressivité.

1.2 Interprétation de la partie électronique - le facteur humain

10Dans le cadre de notre recherche, nous voudrions mieux comprendre le facteur humain dans la performance de la partie électronique ; pour cela nous préférons l’isoler du facteur technique. Ainsi, nous nous intéressons plutôt au performer lui-même qu’à la configuration technologique, même si celle-ci entraîne des conséquences fondamentales dans le processus performatif.

11De prime abord, nous considérons la clarification de la structure musicale comme le principal objectif de l’interprétation. Pour cela, il faut souvent assumer d’éventuels détournements vis-à-vis de cette même structure. Ces détournements peuvent être compris comme le résultat d’une exécution inefficace, mais ils sont aussi, et surtout, acceptés comme le résultat de la composante exploratoire (et interprétative) qu’un performer trouve dans les relations prescrites par le compositeur (comme des patchs, des codes numériques ou même des rapports ou des articles scientifiques), c’est-à-dire, de la vision extérieure d’une œuvre conceptuelle qui est véhiculée au moment de la performance.

12Dès lors, un rapport interactif se tisse entre le performer et l’œuvre elle-même. Le terme interaction est souvent employé dans le contexte de la musique mixte. Évidemment, ce phénomène est inhérent à la question de la complémentarité homme-machine. Dans le cadre de notre étude, ce rapport atteint une dimension encore plus conséquente, car elle rapproche les deux facteurs de notre recherche : humain et technologique. Comme discuté ci-dessus, l’interaction homme-machine dans la musique mixte est une relation bilatérale. Néanmoins, nous observons un autre niveau d’interaction : homme-homme, qui peut être compris comme une interaction totale. Ici, l’intérêt pour notre domaine d’études est en fait la non-inhibition ou la perturbation de ce canal, c’est-à-dire de rendre possible l’existence d’une interaction musicale. Celle-ci naît des relations créées par le compositeur.

13L’auteur Christopher Small mène une recherche consacrée au sens musical de la performance en soulignant l’importance des relations. Dans le cadre de ses recherches, il pose les questions suivantes (Small, 1998 reprises dans Emmerson, 2007) :

-

Quelles sont les relations entre les participants et l’environnement physique ?

-

Quelles sont les relations entre ceux qui y participent [les performers, le public] ?

-

Quelles sont les relations entre les sons produits ?5

14Simon Emmerson, à propos de l’influence de l’interactivité dans le mélange entre les milieux acoustiques et électroniques sur le rapport entre la localisation des performers et le déplacement des sons lors de la diffusion (Emmerson, 2013), constate que notre plaisir pour la musique mixte tend à diminuer lorsque l’on tente de déchiffrer les interactions. C’est-à-dire, la perception de la nature des causes qui provoquent (ou peuvent provoquer) les relations. Certes, cela est nécessaire, mais pas spécifiquement pour l’auditeur, car il sera, en principe, plus intéressé à comprendre la nature des résultats, le produit des interactions. Ainsi, il est essentiel de créer des conditions qui génèrent des « interactions musicales » significatives.

15En mettant en perspective les points ci-dessus avec le moment de la performance dans la musique mixte, on observe un intéressant réseau de relations tissé par des éléments qui composent ce système. Les relations sont dynamiques, non seulement parce que le système possède cette caractéristique par définition, c’est-à-dire en raison de son évolution au long du temps, mais aussi parce qu’elles sont toujours en mutation, pouvant, et devant, varier, entre les différentes reprises d’une œuvre.

16Nous proposons un système dans lequel un performer d’électronique, avec son système instrumental numérique, s’imagine dans le milieu électroacoustique de la même manière qu’un performer d’un instrument traditionnel dans le milieu acoustique. Donc, le système assure l’existence de relations du genre questions-réponses significatives qui aboutissent à une expressivité performative. L’interaction musicale entre les performers est une condition d’existence. Ainsi, avec l’alliance de facteurs humains et technologiques, nous avons établi et défini le concept de Système de relations dynamiques (SRD).

17Ce concept rappelle les pratiques existantes. Elle est influencée par le concept d’interprétation par diffusion acousmatique proposé par Vande Gorne (2002) et par la pratique courante dans la musique mixte improvisée. Dans le cas de l’interprétation acousmatique, l’espace est généralement la seule dimension opératoire et sert à soutenir ou à éclairer les structures musicales créées et fixées par le compositeur. Dans la musique mixte improvisée, le compositeur/performer a toute liberté de manipuler l’électronique, y compris les structures musicales - car elles font partie de l’improvisation, ou encore des paramètres comme la dynamique, l’agogique, l’articulation, le timbre et l’espace.

18Nous nous sommes rendu compte qu’en plus de son importance pour la performance, le SRD a des incidences sur le processus créatif lui-même. L’hypothèse d’une plasticité interprétative de l’électroacoustique implique une prise de conscience de la part du compositeur. Tout d’abord, ce concept s’inscrit au sein de stratégies temps réel ou de stratégies hybrides combinant temps différé et temps réel. Deuxièmement, la mise en œuvre de la partie électroacoustique de l’œuvre doit être conçue dès le départ, parallèlement à la création de la partie acoustique.

19La notation apparaît comme un élément fondamental de la composition - l’acte de composer naît de la possibilité de mémorisation (fixation par l’écriture) et de la confrontation, du choix et de l’opposition entre l’idée et la mémoire. Les symboles notés prennent un caractère de virtualité, car ils font l’objet d’une lecture externe et d’une interprétation conséquente. Cette réalité s’oppose à la composition de la partie électroacoustique dans laquelle, malgré l’utilisation d’environnements virtuels, tout l’espace mémoire est réel, dans le sens où le compositeur contrôle, ou a la capacité de contrôler le résultat final. C’est-à-dire que ce qu’il entend au moment de la composition est très proche de ce que le public entendra.

20Le pouvoir de contrôle d’un compositeur de musique non improvisée est inhérent à l’acte de composer. Cependant, lorsqu’un compositeur écrit une pièce instrumentale, dès lors qu’il choisit un timbre ou une combinaison de timbres, son choix est essentiellement marqué par la désignation d’un certain instrument au début de chaque système musical. Comme une question de tradition et de pratique, la création de la partie instrumentale est faite à partir de certaines prémisses. Un instrument mécano-acoustique a des caractéristiques connues grâce à des études d’organologie et d’orchestration. Le caractère exploratoire des modes de jeux avancés de nos jours, fait déjà l’objet d’une systématisation. Ces prémisses n’existent pas nécessairement pour la composition de la partie électroacoustique. Autrement dit, la composition du son lui-même est souvent le point de départ du processus créatif. A ce titre, ayant cette possibilité, le compositeur fixera ces caractéristiques, même si elles dépendent directement de la gestion des données acquises à partir de l’instrument acoustique. Mais le niveau même de réactivité est souvent pré-paramétré. Lors de la création d’une œuvre électroacoustique disposant d’un certain degré de plasticité, le compositeur doit prendre en compte les paramètres qui doivent nécessairement être prédéterminés et ceux qui peuvent être soumis à des variations. Pour cela, il doit introduire dans le système instrumental numérique la capacité de pouvoir prédéterminer ce qui peut être ajusté dans la performance (soit au moment du concert, soit au préalable). Ainsi, la création de l’interface informatique et le choix de potentielles interfaces sont également cruciaux. Deux attributs s’avèrent donc nécessaires : l’efficacité de la visualisation des processus résultants et l’efficacité de la manipulation. Ceux-ci doivent privilégier la praticabilité d’une performance.

21De plus des implications listées ci-dessus d’un SRD, nous notons les besoins suivants :

-

une notation avec des éléments de nature prescriptive. Pour le performer électroacoustique, il est essentiel d’avoir une prescription d’importance similaire à celle des instruments mécaniques. Par exemple, par rapport à la texture sonore, certains signes peuvent être appliqués de manière similaire : la dynamique avec le crescendo / decrescendo ; l’agogique avec le ritardando / accelerando ; la possibilité de manipuler le timbre, l’articulation et l’adaptabilité à l’espace de la salle de concert avec l’utilisation de réverbérations réglables ;

-

les instructions d’exécution : l’interface informatique est spécifique à une certaine œuvre;

-

la documentation permettant la prise en main ou le portage vers d’autres systèmes informatiques.

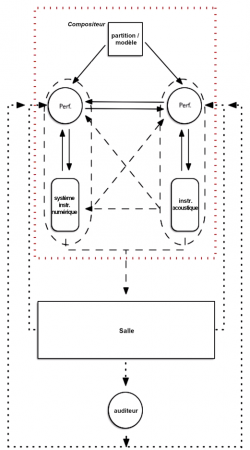

22Ainsi, le schéma ci-dessous (figure 1) montre les différentes relations qui peuvent exister dans un environnement de concert :

Figure 1. Schéma d’un Système de Relations Dynamiques (SRD) dans un environnement de concert.

© José Luís Ferreira

23Dans notre recherche sur l’expressivité musicale dans les musiques mixtes non improvisées, nous sommes arrivés au concept de SRD qui nous a permis de réfléchir à la création et à l’interprétation de ce genre musical. La possibilité d’humaniser l’électroacoustique par l’expressivité performative n’est pas du tout une vision anti-technologique. C’est un constat d’un manque de flexibilité dans l’exécution de musiques mixtes non improvisées et la prédétermination des paramètres et des relations de la partie électroacoustique lors de la performance, qui peut rendre difficile l’emploi de cette technologie. La SRD prétend comprendre l’importance de toutes les relations impliquées dans la création et la re-création musicale.

2 Réadaptation de technologie - Préparer l’avenir en révisant le passé

24La question de la pérennité d’une œuvre musicale électroacoustique a déjà fait l’objet d’études par plusieurs chercheurs et institutions au cours de la dernière décennie (Chowning, 2007), (Guercio, Barthelemy, Bonardi, 2007) et (Roeder, 2006). En raison de phénomènes tels que l’obsolescence (Canazza, Vidolin, 2001) et (Zattra, 2007), il devient urgent de rechercher des solutions pour faire face à la perte inévitable des chefs-d’œuvre du XXe siècle. À l’ère électronique, avec l’utilisation généralisée de la bande magnétique, cette problématique est largement amplifiée, car outre la possibilité d’une maintenance physique, elle nécessite la connaissance de la lecture des données, c’est-à-dire la traduction de langages obsolètes qui empêchent souvent la possibilité de restauration, ou de rénovation.

25La préservation de tous les types de musique électronique est donc un problème qui concerne tous les compositeurs et les interprètes de ce répertoire. D’un côté, la mise en œuvre d’une restauration paraît nécessaire dans le cas d’une œuvre qui aurait plus de 35 ans ; de l’autre, les questions qui émergent sont loin d’être évidentes. Par exemple, le choix du terme « réadaptation » pour qualifier le travail de restauration nous rappelle que souvent il ne s’agit pas seulement de reprendre tels quels les composants d’une œuvre avec la même technologie (ce qui est souvent impossible de nos jours). En vérité, les rôles des uns et des autres se redistribuent vers d’autres acteurs. C’est pourquoi nous préférons le terme « réadaptation » en tant que traduction du terme recasting proposé par (Chadabe, 2001) à d’autres, comme par exemple « refonte ». Nous pensons que le terme « réadaptation » met l’accent sur la nécessité que des adaptations puissent avoir lieu. António de Sousa Dias a fait face à ce problème en transcrivant de Music V vers Csound les fichiers de Jean-Claude Risset, en décidant de conserver la similarité de styles entre les deux langages de programmation, en considérant la structure de programmation et les noms de variables (Sousa Dias, 2007). Malgré cela, la version portée contient des traces qui ne ressemblent pas à l’original.

2.1 Etude de cas : Inharmonique de Jean-Claude Risset

26La réadaptation d’Inharmonique (1977) a eu lieu dans le cadre du projet « Jean-Claude Risset’s Inharmonique : recast and a real time version proposal » en partenariat avec António de Sousa Dias et avec l’accord de Jean-Claude Risset. Les objectifs de ce projet étaient le transfert intégral de technologie avec sa documentation et la proposition d’une version en temps réel de cette œuvre (Sousa Dias et Ferreira, 2013). Parallèlement aux objectifs principaux mentionnés, deux questions majeures se sont posées : la pertinence de cette reprise et la pertinence de transcrire une œuvre musicale mixte en temps différé pour une synthèse et un traitement en temps réel.

27La préparation du portage d’Inharmonique de Jean-Claude Risset présente de nombreuses difficultés, comme le manque de documentation et la manipulation de langages obsolètes. Il s’agit d’une œuvre mixte en temps différé dont la matière sonore a été générée par synthèse avec Music V (Mathews et al., 1969). Comme ce langage n’est plus disponible, d’autres applications ont été utilisées afin de traduire efficacement les codes originaux. Il est important de mentionner que le compositeur lui-même a participé au début de cette recherche en mettant à disposition ses archives. Avec cette réadaptation, nous avons également cherché, dans le cadre de notre recherche, notamment pour ce qui concerne les SRD, à atteindre une stratégie en temps réel adéquate pour cette œuvre, ce qui implique une étude des problématiques, comme l’efficacité des stratégies choisies, l’importance de l’interface (en cours d’implémentation) et, avec cela, l’ouverture à une liberté performative. S’agissant d’une œuvre créée par un autre compositeur, avec un paradigme d’interaction différent (temps différé), ce projet soulève également des questions liées à la légitimité, la fidélité et l’autonomie de cette conversion au temps réel par rapport à la version originale.

2.2 Transfert de technologie - de Music V à Csound

28Inharmonique a été créée en 1977 et son titre fait allusion à l’utilisation d’un ensemble de structures inharmoniques composées comme des accords, ceux-ci étant susceptibles de subir certaines transformations (Risset et al., 2002). La bande magnétique, créée à l’IRCAM, présente diverses stratégies et formes de synthèse sonore grâce à l’utilisation intensive du logiciel Music V. En dehors de sa qualité musicale, cette œuvre a acquis une grande importance dans le contexte des études sur l’informatique musicale grâce au rapport de Lorrain (1980). Ce rapport inclut dans sa documentation de nombreux orchestres et partitions utilisés à l’origine par Risset. En conséquence, le matériel produit par l’analyse de Lorain a été largement discuté dans plusieurs publications dans ce domaine d’études (voir, par exemple, Dodge et Jerse, 1985) et a rendu possible l’adaptation du code à d’autres langages de synthèse sonore.

29Actuellement, cette œuvre survit grâce à sa version originale sur bande magnétique, créée avec un taux d’échantillonnage de 20 KHz, et en raison des problèmes liés à sa dégradation dans le temps (avec ce que l’on appelle le bruit de fond), sa conversion au format numérique (et le passage au taux d’échantillonnage de 44,1 KHz) s’est faite tardivement.

30La réadaptation technologique a demandé une analyse approfondie de la documentation existante : le rapport de Denis Lorrain (1980) déjà mentionné, les archives du compositeur lui-même et le matériel créé par Sousa Dias, en langage Csound, à partir du rapport précité. Ce dernier s’est avéré essentiel comme point de départ du projet, car il contient une description détaillée d’une grande partie des processus numériques mis en œuvre par Risset, permettant ainsi sa recréation. Selon Risset, Lorrain « a choisi les séquences les plus caractéristiques de la bande, il a reconstitué les partitions (...) » (Risset dans Lorrain, 1980). Ainsi, l’objectif principal de ce rapport est l’analyse de ces processus et non la reconstruction totale de l’œuvre. Donc, il y a des lacunes dans les informations que nous avions et nous devons y faire face. Hormis la mémoire du compositeur et quelques notes prises par lui, datées de cette époque, la documentation relative aux parties de la piste magnétique que Denis Lorrain n’a pas incluses dans son rapport est pratiquement inexistante. Une autre lacune est aussi l’absence de documentation concernant le paramétrage des traitements (transpositions, filtrages et réverbérations) intervenus dans une phase postérieure à la synthèse dans Music V. Ce manque d’information fait que ce transfert technologique et la réalisation de ses objectifs deviennent un processus extrêmement lent et laborieux. Malgré les informations sur les procédures numériques utilisées, le manque d’informations sur les paramétrages locaux ne peut être comblé qu’au moyen de données recueillies à partir de la partition et acquises grâce à la bande magnétique, par des procédures d’analyse spectrale et de re-synthèse. L’une des difficultés, pourtant surmontée, est directement liée au procédé algorithmique que Risset a utilisé pour créer les sons des cloches et générer des séquences d’événements : les routines PLF (PLay First pass).

31Dans Music V, le processus de génération d’un fichier audio à partir des paramètres de la partition et de l’orchestre est divisé en trois étapes. La première étape définit les paramètres et les fonctions en générant des événements/notes de la partition, dans lesquels les paramètres et les fonctions sont établis. La deuxième étape est liée à l’ordonnancement de la séquence d’événements dans le temps et la troisième étape est celle de la génération du son proprement dit, les cartes perforées étant lues en fonction des réglages des instruments de l’orchestre. Chacune de ces étapes est appelée « Pass » (Pass I, Pass II et Pass III). Les routines PLF sont des algorithmes, programmés en FORTRAN, qui permettent, lors de la première étape, de générer de nouvelles notes et/ou séquences de notes (Mathews et al., 1969).

32Il existe de nombreuses similitudes entre les programmes Music V et Csound, et ce dernier est la suite du développement du premier. Le paradigme de la programmation sonore numérique a subi plusieurs changements au cours des 20 dernières années et le processus de génération algorithmique, utilisé à l’origine par Risset, n’existe plus dans Csound. Ainsi, Sousa Dias a transcrit les routines PLF vers Csound, en utilisant le logiciel OpenMusic comme étape intermédiaire afin de générer les événements à lire par Csound (Sousa Dias, 2003). Ce travail a permis ainsi le transfert vers ce langage. Csound utilise une syntaxe efficace et assez simple. Avec une certaine connaissance de sa syntaxe, il est possible de décoder rapidement les significations et représentations de ses modules. Avec la transcription complète (ou transcodage) de Music V vers Csound, nous atteindrons deux objectifs. Le premier, l’obtention de la réadaptation technologique totale de cette œuvre et le second, sa documentation. Les fichiers d’Inharmonique, rédigés en langage Csound, contiennent une grande partie des données et informations nécessaires qui permettent la poursuite de son étude et, à l’avenir, la possibilité de réaliser un nouveau transfert technologique vers d’autres paradigmes de programmation. Ainsi, la pertinence de réadapter une œuvre historique comme Inharmonique, qui a marqué la musique mixte de manière ineffable, devient évidente.

2.3. Réadaptation technologique - Implémentation du système temps réel

33Le deuxième objectif de ce projet est de créer une version temps réel de cette œuvre. Ainsi, la partie électronique sera plus perméable et sera plus adaptable à la temporalité de la soliste. Même si la grande partie des séquences créées par Risset sera synthétisées en temps réel, nous avons choisi de maintenir la prédétermination des paramètres de synthèse et d’en conserver les relations temporelles. Du fait du précédent transfert effectué par Sousa Dias (2007), il nous a semblé évident d’utiliser la combinaison des applications Csound et Max. Le moteur de synthèse sera réalisé par Csound et toute la gestion de l’analyse vocale, la structuration, la gestion des événements et de la réponse seront effectués par Max.

34Comme décrit précédemment, le processus de création de notes et d’événements dans Inharmonique était, à l’origine, dépendant des routines PLF. En raison des caractéristiques inhérentes au logiciel Csound, ce processus a été perdu dans la transcription de Sousa Dias, réalisée à partir des données du rapport de Lorrain. En analysant le score Csound obtenu, nous avons constaté que le nombre d’événements de celui-ci était en moyenne dix fois supérieur au nombre d’événements du score Music V original. Cette quantité d’événements devient extrêmement compliquée à générer et à gérer en temps réel, ce qui aggrave le fait que certains résultats sont disparates par rapport à l’original et que plusieurs adaptations doivent être faites pour la multitude d’événements qui composent la partition électroacoustique de cette œuvre. En revenant au principe de l’utilisation des routines PLF en temps réel, la question de la gestion des événements deviendrait plus simple et facilement manipulable, mais ne résoudrait pas la disparité des résultats obtenus. Mais récemment, nous avons obtenu, des archives du compositeur, le code original des routines PLF, écrites en Fortran. Ainsi, de manière similaire au processus proposé par Baudouin (2007), ces routines PLF, ont été transcrites en JavaScript. Ce processus n’est efficace que grâce aux capacités de communication du logiciel Max avec d’autres langages de programmation, et dans ce cas précis, JavaScript, avec l’utilisation de l’objet js~. Nous pouvons donc établir la communication entre Max et le moteur de synthèse, avec une plus grande efficacité et économie d’information, à travers l’objet Max « js~ » qui sert de médiateur entre les instructions PLF et Csound. Cette transcription réalisée par Sousa Dias s’est également avérée avantageuse et efficace, car elle a permis de diminuer largement les disparités constatées précédemment entre la version recréée à partir de la description faite dans le rapport de Lorrain et la version originale. Un autre avantage de l’utilisation de Csound comme moteur de synthèse est que, ayant certains principes et processus de langage en commun (ou très proches) avec Music V, il permet de préserver la saveur de l’écriture « idiomatique » par rapport au langage de programmation utilisé à l’origine. Ainsi, le langage Csound, permet de faire le pont idéal entre Music V et Max. Avec ce procédé, la stratégie trouvée pour déclencher les algorithmes de Risset en temps réel est quelque peu similaire au procédé original.

35La faisabilité de la version temps réel de ce travail dépend du transfert de technologie, principalement en raison du besoin de reconstruction des événements créés à partir des routines PLF. Comme mentionné précédemment, il y a un manque de documentation concernant les paramétrages dans les sections non couvertes par le rapport de Lorrain, les seules sources étant la partition et la version numérique de la bande magnétique. Le travail d’analyse spectrale et de re-synthèse est entrepris afin de rendre possible, non seulement la réussite de ce transfert, mais aussi la reconstruction des routines PLF, afin de permettre la version temps réel, dont les résultats partiels ont été présentés au compositeur (Sousa Dias et Ferreira, 2013).

36Un objectif secondaire de ce projet est la réédition de la partition. La partition originale se présente au format d’une œuvre mixte en temps différé, et donc organisée selon les apparitions temporelles du matériel musical de la bande. Celle-ci a le format typique d’une partition d’une œuvre mixte en temps-différé, dans laquelle le temps est structuré en minutes et secondes avec l’aide graphique des événements et du matériel de la bande. Dans la nouvelle édition, la partition sera organisée principalement de manière quantitative. Avec la proposition d’une version en temps réel d’Inharmonique, une nouvelle version de la partition de cette œuvre devient indispensable.

37Dans la version temps réel, tous les événements seront contrôlés par la soliste grâce à un système de suivi de partition. Le performer électronique devient responsable de la gestion du patch MAX et du contrôle des niveaux d’intensité de la voix et de l’électronique. Le schéma ci-dessous (figure 2), permet d’observer notre stratégie. Le sous-patch pitchtracker_InHarmonique.maxpat se charge de l’analyse du signal d’entrée, à savoir la voix de la soliste, en prenant les éventuelles fluctuations de hauteur souhaitées par le compositeur.

38Outre la précision nécessaire (valable pour les deux cas - temps différé et temps réel) dans ce travail, il y a l’adaptation dans l’accord de la voix de la chanteuse. Même si la partie vocale a été composée entièrement en tempérament égal, dans certaines parties le compositeur indique que la soliste doit s’adapter à l’inharmonicité des accords générés par l’électronique. Ainsi, la version temps réel souligne ces caractéristiques qui sont inexistantes dans la version originale.

Figure 2. Schéma du patch jcr_inharmonique_RT.maxpat

© José Luís Ferreira

39Le sous-patch filternotes.maxpat permet la gestion du sous-patch sections.maxpat. Chaque sous-patch contient l’organisation temporelle et toutes les informations (les routines PLF, décrites ci-dessus) qui permettent la génération d’événements en temps réel. Le sous-patch playEco~ simule le traitement que Jean-Claude Risset a utilisé dans la reproduction du fragment mélodique de la version originale, figé dans l’interprétation et le timbre d’Irène Jarsky, qui apparaît vers la fin de l’œuvre (Risset, 2002). Ce fragment mélodique peut désormais être capté (et stocké dans l’objet buffer~ Inharmonique) lors de la performance de la section V, traité puis reproduit lors de la section VIII. Ainsi, ce fragment mélodique est remplacé par la voix captée en temps réel. Ce procédé permet désormais une plus grande cohésion et fluidité du timbre entre la partie électronique et la partie vocale, rendant ainsi la partie électronique plus souple et adaptable à chaque chanteuse lors de différentes

Conclusion

40Le portage d’une œuvre musicale mixte en temps différé vers une version temps réel, avec des traitements et des synthèses, met en lumière des problématiques concernant l’esthétique de l’authenticité et la fidélité à l’œuvre. Tout cela est intimement lié à des facteurs technologiques et de performance.

41Les différences entre les systèmes de synthèse Music V et Csound6 soulèvent la question suivante : avec tout le bénéfice des résultats que peuvent nous offrir les systèmes numériques modernes, dans quelle mesure peut-on « mettre à jour » le travail avec cette réadaptation et rester fidèle à l’original ? En fait, l’oreille sert toujours de filtre. Entre les deux versions, il y a des différences notables de timbre. Celles-ci sont principalement dues à la modification de taux d’échantillonnage. Grâce à une plus grande richesse spectrale, l’oreille est enrichie.

42Cela a imposé un réglage de détails afin de rapprocher cette version de l’original sur le plan sonore. L’existence inévitable de ces différences est au moins compensée par la meilleure qualité sonore et l’absence de bruit de fond. Ainsi, la question de l’authenticité de l’œuvre se pose. Mais l’avantage de collaborer avec le compositeur rend cela moins grave dans le sens où, en définitive, le dernier mot est celui du compositeur lui-même. Dans ce projet, Jean-Claude Risset a validé la démarche consistant à conditionner l’amélioration de la qualité sonore à l’approximation du timbre de la version originale.

43La question de la fidélité gagne en pertinence avec l’ouverture des possibilités expressives de cette version temps réel, et ceci est intimement lié au facteur performance. En effet, l’une des hypothèses initiales pour créer une version en temps réel était l’utilisation de la version transférée (temps différé) uniquement avec l’intégration de la voix de la performeuse en temps réel. Sans doute, ce projet serait-il moins complexe, la question de la fidélité ne serait plus mise en cause, et nous rendrions encore possible la pérennité de cette œuvre. Mais la fixité du temps différé ne permettrait pas ce que la flexibilité pourrait apporter aux nouvelles formes d’expressivité de cette œuvre. En effet, la fixité d’une pièce électronique mixte préserve la volonté d’un compositeur. Le contenu expressif d’une œuvre fixe n’a pas moins de valeur que celui atteint en concert par les performers. Ce serait mettre en question l’expressivité de toute œuvre musicale acousmatique. Ce n’est clairement pas notre intention. Nous avons finalement opté pour la souplesse du temps réel qui donnera lieu à des versions probablement différentes d’Inharmonique. La responsabilité de la fidélité passe désormais sur les épaules des performers. Mais, en fait, ce n’est rien qui ne se produise déjà avec toute œuvre musicale qui n’utilise pas de moyens électroniques. C’est ce que nous entendons avec le concept de systèmes de relations dynamiques : rendre une œuvre électronique mixte aussi dépendante des performers que toute autre œuvre du répertoire acoustique.

44Enfin, nous pensons que la réalisation de ce projet apportera une contribution substantielle à la documentation d’Inharmonique, garantissant ainsi sa pérennité et offrant de nouvelles possibilités pour la performance de cette œuvre.

Bibliographie

Baudouin, Olivier (2007), « A Reconstruction of Stria », Computer Music Journal 31(3). https://www.jstor.org/stable/40072595

Canazza, Sergio, Vidolin Alvise (2001), «Introduction: Preserving Electroacustic Music », Journal of New Music Research, 30(4). https://doi.org/10.1076/jnmr.30.4.289.7494

Chadabe Joel (2001), « Preserving Performances of Electronic Music », Journal of New Music Research, 30(4). https://doi.org/10.1076/jnmr.30.4.303.7485

Chowning John (2007), « Stria: Lines to its Reconstruction », Computer Music Journal, 31(3). https://www.jstor.org/stable/40072591

Dodge Charles, Jersey Thomas (1985), Computer Music: Synthesis, Composition, and Performance, New York, Schirmer Books.

Emmerson Simon (2007), Living Electronic Music, Aldershot, Ashgate, England.

Emmerson Simon (2013), « Rebalancing the discussion on interactivity », Electroacustic Music in the context of interactive approches and networks, EMS13, Lisboa. http://www.ems-network.org/IMG/pdf_EMS13_emmerson.pdf

Ferreira José Luís (2011), « Une approche de l’électronique « live » », Revue Francophone d’Informatique et Musique, numéro 1. https://doi.org//10.56698/rfim.97

Ferreira José Luís (2016), Música Mista e Sistemas de Relações Dinâmicas, Thèse de doctorat, Universidade Católica Portuguesa, Porto. http://hdl.handle.net/10400.14/24086

Guercio Marielle, Barthelemy Jérôme, Bonardi Alain (2007), « Authenticity Issue in Performing Arts using Live Electronics », Proceedings of the 4th Sound and Music Computing Conference (SMC07), Lefkada, Greece.

Lemouton Serge, Pottier Laurent, Warnier, Jacques, Bonardi, Alain (2019), « Présentation des actions du groupe de travail Afim “archivage collaboratif et préservation créative” », Journées d’Informatique Musicale, Bayonne. https://hal.science/hal-03111493/

Lorrain Denis (1980), Analyse de la bande magnétique de l’œuvre de Jean-Claude Risset “Inharmonique”, Centre Georges Pompidou (Rapport IRCAM n° 26/80), Paris.

Mathews Max et. al. (1969), The technology of computer music, Cambridge, MIT press.

Roeder John (2006), « Preserving Authentic Electroacoustic Music: the InterPARES Project », Proceedings of the IAML-IASA Congress, Oslo, Norway.

Risset Jean-Claude (2002), « Examples of the musical use of digital audio effects », Journal of New Music Research, 31(2). https://doi.org/10.1076/jnmr.31.2.93.8092

Risset Jean-Claude, Arfib Daniel, Sousa Dias António, Lorrain Denis, Pottier Laurent (2002), « De “Inharmonique” à “Resonant Sound Spaces” : temps réel et mise en espace », Journées d’Informatique Musicale, AFIM, Marseille. https://hal.science/hal-02982725/

Small Christopher (1998), Musicking: The Meanings of Performing and Listening. Wesleyan University Press, Middletown.

Sousa Dias, António (2003), « Transcription de fichiers Music V vers Csound au travers de OpenMusic ». Journées d’Informatique Musicale, AFIM, Montbeliard. https://hal.science/hal-02994145/

Sousa Dias António (2007), « Deux contributions à la pédagogie de la musique électroacoustique et l’informatique musicale », Journées d’Informatique Musicale, AFIM, Lyon. https://hal.science/hal-03105424/

Sousa Dias António, Ferreira José Luís (2013), « Jean-Claude Risset’s “Inharmonique” (1977): recast and a real time version proposal », Electroacoustic Music in the context of interactive approaches and networks EMS13, Lisboa, Portugal. http://www.ems-network.org/ems13/EMS13Abstracts.html

Tiffon Vincent (2005), « Les Musiques Mixtes : Entre Pérennité et Obsolescence », Musurgia, 12(3). http://www.jstor.org/stable/40591401

Vande Gorne Annette (2002), « L’interprétation spatiale. Essai de formalisation méthodologique », DÉMéter. https://archive-demeter.univ-lille.fr/ancien-demeter/demeter.revue.univ-lille3.fr/lodel9/indexde4c.html%3Fid=466.html

Zattra Laura (2007), « The Assembling of Stria by John Chowning: A Philological Investigation », Computer Music Journal, 31(3). https://www.jstor.org/stable/40072593

Tous les liens ont été vérifiés à date de publication.

Notes

1 Dans la thèse de Ferreira, l’auteur réalise aussi une étude sur Ricercare una melodia (1985) de Jonathan Harvey. Cependant, pour cette traduction, nous allons seulement prendre en compte Inharmonique.

2 Nous nous référons notamment au contexte professionnel des institutions comme l’Ircam à Paris.

3 NDT. Quant à la musique mixte comme genre Tiffon affirme : « la musique mixte, plus de cinquante ans après sa création, reste un genre équivoque, énigmatique, dont on conteste encore tour à tour la légitimité, la pertinence ou l’autonomie » (Tiffon, 2005).

4 NDT. Dans le texte original en portugais, Ferreira adopte le terme “performance” et nomme de “performer” la personne assurant ce rôle. Bien que ce terme ne soit pas pris comme tel en langue portugaise, Ferreira soutien : “Nous préférons, dans le cadre de nos recherches, utiliser le terme performer pour désigner le musicien dont le but premier est la réalisation d'une partition en son, plutôt que les désignations habituelles d'exécutant ou d'interprète en langue portugaise, et parce que nous considérons que celles-ci ne sont pas suffisantes pour caractériser cette tâche. Le terme performer, en portugais, est rarement utilisé dans les arts musicaux.” (Ferreira, 2016, p.49-50) Mais pour Ferreira "le performer ne peut pas être seulement un " exécutant " ou seulement un " interprète " ou seulement un simple " véhicule ". C'est, sans doute, dans sa condition de lecteur de signes que l'interprète devient un moyen d'expression musicale dans le champ performatif" (Ferreira, 2016, p.66), ce dernier compris comme un "espace non neutre dans lequel toutes les composantes, même extra-musicales, influencent/conditionnent et sont orientées vers l'œuvre musicale (le moment dans lequel elle existe)" (Ferreira, p.52, note pied de page). Pour notre traduction, nous choisissons les termes performance et performer.

5 What are the relationships between those taking part and the physical setting? What are the relationships among those taking part? What are the relationships between the sounds that are being made? (Small, 1998, p.193)

6 Nous utilisons ici le terme de systèmes de synthèse, car en fait, dans les deux versions, la version finale de l'œuvre musicale ne dépend pas seulement du résultat direct des logiciels mentionnés, mais d'un ensemble d'opérations et de routines les impliquant.