Essai d’une « électronique de chambre » : il n’est plus là, je suis là, pour flûte et dispositif électronique

Guilherme Carvalho octobre 2011

octobre 2011DOI : https://dx.doi.org/10.56698/rfim.155

Résumés

Résumé

Nous nous intéressons dans ce texte à quelques enjeux d’écriture (instrumentale et électronique) pour la création d’un rapport entre instrument soliste et partie électronique se rapprochant autant que possible de celui qui existe entre deux instruments dans la musique de chambre instrumentale. La discussion s’appuie sur une pièce récente pour flûte et dispositif électronique.

Abstract

We study in this text some writing issues (both instrumental and electronic) for the creation of a relation between soloist instrument and electronic part that resembles as much as possible that between two instruments in instrumental chamber music. The discussion is developed around a recent piece for flute and electronics.

Index

Index de mots-clés : musique mixte, composition, musique de chambre.Index by keyword : Composition, chamber music, mixed music.

Texte intégral

Introduction

1Dans le vaste répertoire pour instrument soliste et dispositif électronique, nous trouvons différents rapports entre l’instrument (et, en conséquence, l’instrumentiste) et tous les sons diffusés par les haut-parleurs (ce qui est couramment appelé la « partie électronique »). Ces deux pôles sonores, aux rayonnements presque inévitablement différents, sont placés en opposition ou en fusion, à différents degrés, selon plusieurs dimensions musicales. Nous avons voulu nous interroger sur la possibilité d’établir un rapport entre eux qui se rapprocherait de celui que l’on retrouve dans la musique de chambre instrumentale : un lien dynamique, où les deux côtés « écoutent » et s’adaptent constamment au résultat global, selon ce qui est écrit pour chaque partie.

2Bien sûr, il est possible d’affirmer que l’instrumentiste qui joue seul.e avec un dispositif électronique (que celui-ci soit ou non contrôlé pendant la performance par quelqu’un d’autre) fait, en un certain sens, toujours de la musique de chambre. Cependant, nous voulons nous intéresser à une situation où la partie électronique elle-même prévoit, dès son écriture, la possibilité de réagir, de s’intégrer ou de se différencier de l’instrument.

3Nous verrons que cela passe, naturellement, par un traitement du son en temps réel, mais pas uniquement. Dans le but d’établir au mieux cet espace de dialogue entre instrument et partie électronique, nous prendrons en compte l’espace, les matériaux employés (avec leur dynamique et leur temporalité), les réactions et les réponses d’une partie à l’autre.

1. Spatialité

4Les pièces qui mettent en œuvre des moyens électroniques visent très souvent l’immersion de l’auditeur dans un espace sonore – une immersion physique, et pas simplement musicale ou cognitive. Nous sommes donc fréquemment en présence de nombreux haut-parleurs, la plupart du temps disposés autour du public. Les différentes techniques de diffusion et de spatialisation (vbap, Ambisonics, WFS,...) attestent également des efforts pour créer un espace musical propre au dispositif électronique (ou à chaque pièce) et qui occupe tout l’espace physique où a lieu la performance. Ce genre de rayonnement et de spatialité est plus proche, si on se réfère à la musique instrumentale, de celui d’un grand orchestre que de celui d’un duo ou d’un ensemble de chambre.

5Pour la pièce il n’est plus là, je suis là1, nous avons voulu occuper un espace plus petit, et rapprocher le rayonnement global (instrument et partie électronique) de celui d’un duo. Le dispositif consiste ainsi uniquement en deux haut-parleurs disposés de chaque côté de l’instrumentiste, à hauteur de l’instrument. La réduction à une stéréo relativement serrée n’implique pourtant pas un abandon de toute composition de l’espace. Au contraire, la différenciation des plans sonores, des masses et des localisations est d’autant plus expressive qu’elle a lieu en interaction avec le son direct de la flûte. Nous verrons plus loin que cet aspect spatial s’appuie aussi sur les morphologies des sons diffusés.

6Ce choix de diffusion implique également que l’acoustique ambiante a une influence directe et assez sensible sur le résultat sonore : aucun effort n’est fourni pour imposer ou simuler un espace plus grand (ou avec des caractéristiques différentes) que celui défini par les deux haut-parleurs.

7Nous avons encore constaté que cette réduction concentre l’attention du public sur l’interprète et sur les gestes qui ont lieu sur scène, ce qui va également dans la direction que nous visions. L’enjeu ici n’est donc plus celui d’une immersion, mais bien d’une projection de l’écoute (ou de son attraction) vers l’action musicale et instrumentale : ce qu’il y a à entendre est localisé, sans pour autant perdre en profondeur ou en complexité.

8Ce genre de diffusion n’est pas sans rappeler celui de Mantra, de K. Stockhausen, où des haut-parleurs sont placés sous les pianos. Si nous recherchons comme lui une fusion spatiale entre partie électronique et sons instrumentaux, la diversité des matériaux diffusés est ici plus grande et implique d’autres rapports de timbre (donc de temporalité) que ceux présents avec la modulation en anneau.

2. Matériaux

9Dans l’écriture de la musique de chambre instrumentale, l’écriture du dialogue entre les instruments passe souvent par l’agencement des similarités et des différences morphologiques de chaque partie, et par la gestion des articulations temporelles que ces matériaux définissent (séparément et en interaction). La partie électronique de il n’est plus là, je suis là, bien que n’exigeant pas de synchronicité stricte de la part de l’instrumentiste, a été écrite en visant ces possibilités d’agencement et de gestion. Il en va bien sûr de même pour la partie de flûte.

10Les sons réalisés en studio qui sont présents sur la bande proviennent souvent d’échantillons de flûte ; ils reprennent des gestes et des morphologies que l’on retrouve dans la partition, et dépassent parfois les possibilités instrumentales d’articulation. D’autres sons proviennent de sources volontairement très différentes de la flûte, ou sont synthétiques. Bien évidemment, il ne s’agit jusqu’ici que de pratiques courantes dans la musique mixte : cela permet de rapprocher ou d’éloigner (en termes de timbre) la partie électronique de la parte instrumentale.

11Nous avons voulu que la flûte réalise aussi ces déplacements de sa sonorité, que ses modes de jeu se rapprochent occasionnellement d’un univers plutôt caractéristique de l’électronique et des sons traités par ordinateur. Ainsi, la flûte est parfois modifiée ou « désaccordée » par l’utilisation de glissandi, de bisbigliandi, de multiphoniques, et de doigtés alternatifs (provenant souvent eux-mêmes de ces effets). Ces modes de jeu furent choisis de façon à préserver la fluidité du jeu « normal », pour que ces sonorités modifiées puissent garder une agogique instrumentale. Nous avons donc souvent employé des positions qui ne diffèrent d’un doigté usuel que par le retrait ou l’ajout d’une clé.

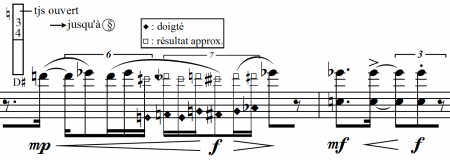

Figure 1

Gammes microtonales graves2

Figure 2

Microtonalité et multiphonique

Figure 3

Bisbigliandi

12Ces techniques permettent d’obtenir de façon très contrôlée une activité interne à la note jouée, qui serait difficile à exécuter sans cette proximité des doigtés usuels. Notons qu’une telle précision dans l’écriture du geste instrumental n’a été possible que grâce à une collaboration très proche avec l’instrumentiste. Une grande partie du matériau instrumental provient en fait de ces gestes caractéristiques : le contenu harmonique et mélodique est souvent dicté par le fonctionnement même de l’instrument (au lieu d’être ce qui détermine les gestes).3

13Le dialogue entre les deux parties, géré de cette façon quant au timbre et à la temporalité gestuelle, s’articule également dans l’espace : la localisation et la spatialité des éléments de la partie électronique dépend de leur morphologie et de leur similarité avec le matériau instrumental. Ainsi, certains sons de flûte peu modifiés peuvent être diffusés au centre des deux haut-parleurs, pour fusionner avec le son direct de l’instrument, ou déplacés pour établir avec celui-ci des rapports spatiaux. Nous verrons que cette dimension spatiale est également importante pour les réactions et les réponses d’une partie à l’autre.

3. Réactions

14Il est clair qu’un.e instrumentiste adapte toujours son jeu pendant l’interprétation d’une œuvre, réagissant à l’environnement sonore qu’il ou elle contribue à créer. En particulier, les ajustements d’intensité peuvent être très fins et sont constants, au point de pouvoir être faits presque inconsciemment (sans que cela ne relève d’une décision ponctuelle d’interprétation) et de ne pas être perceptibles comme des ajustements par les auditeurs (l’équilibre est perçu plus que le maintien de cet équilibre).

15Dans un ensemble instrumental, ces réactions et ajustements concernent chaque instrumentiste ; mais l’interprète seul.e face à un dispositif électronique ne peut pas toujours attendre de celui-ci qu’il l’écoute de cette façon.4 Ce problème peut bien sûr être minimisé par l’écriture d’une partie électronique qui ne dépasse pas les capacités dynamiques de l’instrument, du moins lorsque celui-ci joue, ou qui profite d’une synchronisation stricte pour opérer ces ajustements « à l’avance », en temps différé.

16Un dispositif électronique qui réagit à un instrument n’est plus aujourd’hui un outil rare. Nous avons en effet, depuis plusieurs années, des outils très efficaces pour l’analyse et le traitement du son en temps réel. Cependant, une grande partie de ces traitements vise soit une transformation du son instrumental, soit un contrôle par l’instrument d’un processus de synthèse ; un peu plus rarement, ils visent ces deux actions simultanément (une transformation du son contrôlée elle-même par l’instrument). Il nous semble qu’il est moins fréquent dans le répertoire que le son instrumental contrôle la diffusion d’une partie électronique écrite en temps différé.

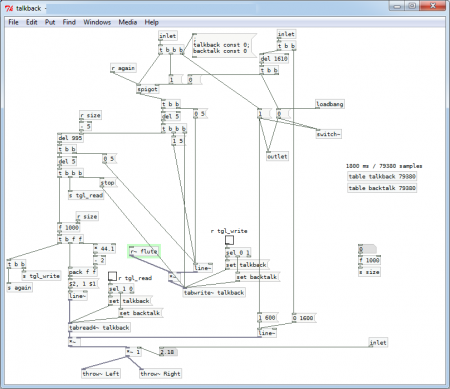

17Dans il n’est plus là, je suis là, les parties instrumentale et électronique ne sont pas strictement synchronisées : 11 fichiers réalisés en studio sont déclenchés lors de certains points d’orge de la partition (donc sans un point de départ rythmiquement déterminé), et n’imposent pas une vitesse d’exécution à l’instrumentiste, ou des « points de rencontre ». Nous avons choisi de ne pas limiter systématiquement les amplitudes de cette partie électronique. Cela assurerait certes une compatibilité dynamique permanente avec la flûte, mais contraindrait assez fortement les possibilités expressives que nous visions. Notre choix a donc été de permettre à la flûte de modérer en temps réel l’amplitude de la partie électronique ; le dispositif joue toujours sa propre partie, mais réagit au jeu de la flûte et s’y adapte.

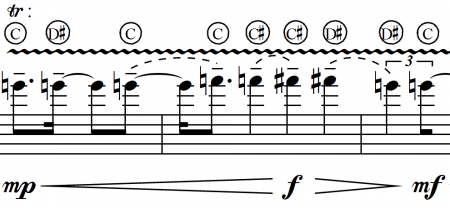

18Nous utilisons pour cela un sous-patch dont le paramètre principal change selon les sections5, et qui est essentiellement un suiveur d’enveloppe.

Figure 4

Contrôle de l’amplitude de l’électronique par le son de la flûte

19Cette technique préserve non seulement une grande liberté dans le choix et l’emploi des matériaux dans la partie électronique, mais donne également à l’instrumentiste beaucoup de marge pour se placer par rapport à ces objets, sachant qu’un équilibre sera toujours possible.

20Bien sûr, l’écriture électronique ne s’appuie pas uniquement sur cet ajustement dynamique en temps réel. Outre cette réaction réelle, l’illusion d’une réactivité est renforcée par l’éventuelle proximité des matériaux des deux parties (dans le temps, les morphologies, et par leurs dispositions dans l’espace). En connaissant la partie électronique, l’instrumentiste peut construire son interprétation à partir de ces points de repère, susciter des « réactions » supplémentaires, et choisir de mettre en avant de cette façon aussi un dialogue caractéristique de musique de chambre.

4. Réponses

21Outre les réactions et adaptations de chaque partie à l’autre et au résultat global, nous avons voulu mettre en place un dialogue entre l’instrument et le son diffusé par les haut-parleurs basé sur des réponses au sens dynamique et motivique. Comme pour la réactivité de la partie électronique, une grande partie des possibilités de réponse est écrite en temps différé. Il s’agit simplement de matériaux communs anticipés ou repris d’une partie à l’autre. Encore une fois, l’absence de synchronicité stricte ou prédéfinie entre instrument et dispositif électronique permet la construction de différentes réponses selon l’interprétation.

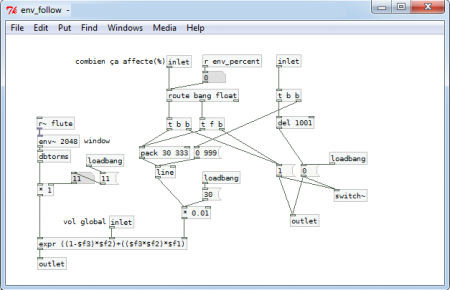

22Mais dans une section de la pièce, un autre type de réponse est présent : le son de la flûte est enregistré en temps réel et immédiatement rejoué inversé. Le sous-patch qui effectue ce traitement emploie deux buffers (un pour l’enregistrement et un pour la lecture) ; le temps d’enregistrement (et donc le temps à attendre avant la première réponse) est modifiable.

Figure 5

Enregistrement et lecture inversée de la flûte (en temps réel)

23Ce traitement assez simple s’est révélé, pendant la composition, être d’une grande richesse expressive. En effet, la taille de la fenêtre d’enregistrement modifie considérablement la dimension sur laquelle ce traitement agit.6 Autour de 1000 ms, ce sont des motifs et des gestes qui apparaissent inversés, assez proches (temporellement) de leurs « originaux » pour constituer une réponse, mais suffisamment éloignés pour en être distingués. Avec des temps beaucoup plus courts (150 ms et moins), la transformation s’opère plutôt sur le timbre ; avec des durées plus longues, des phrases entières se constituent.7 Il est important de noter que ce traitement dépend fortement, par sa définition même, de la morphologie du matériau auquel il s’applique. La temporalité de celui-ci doit être prise en compte pour le choix de taille de la fenêtre d’enregistrement, selon le résultat voulu.

24Pour favoriser la fusion entre ce son transformé en temps réel et le son direct de l’instrument, nous avons choisi de diffuser la sortie du sous-patch au centre des deux haut-parleurs. La présence supplémentaire des sons faits en temps différé, qui occupent tout l’espace et continuent de dialoguer avec la flûte, fait qu’il est effectivement impossible, par moments, de distinguer le son instrumental direct et le son inversé. Le contrepoint ainsi créé rend le résultat global sensiblement différent d’une simple superposition d’éléments – ce phénomène d’émergence, encore une fois, est courant en musique de chambre.

Conclusion

25Les rapports qui s’établissent entre instrument(s) et partie électronique dans une pièce mixte peuvent toujours être perçus comme un dialogue, une interaction, semblable en plusieurs points à ce qui a lieu dans une pièce purement instrumentale. Nous avons voulu approfondir et mettre en évidence, dans l’écriture d’une pièce pour instrument seul et dispositif électronique, les spécificités caméristes de ces rapports. L’expérimentation que nous avons pu faire en termes d’espace (autant pour la localisation que pour la spatialité), de réactivité et de construction de réponses du dispositif, nous a finalement mené à des outils et des considérations qui ont des retombées sur d’autres contextes : effectif plus grand, plus de points de diffusion, rapports plus variés entre son direct et sons diffusés. L’opposition que l’on peut formuler, pour le répertoire instrumental, entre musique de chambre et musique orchestrale n’est pas complètement maintenue dans notre approche d’une « électronique de chambre » : il serait intéressant de s’interroger également dans la musique orchestrale sur les rapports entre instruments, et entre ceux-ci et l’espace, par exemple, pour en tirer des thèmes de recherche nouveaux pour la musique mixte. Nous pourrons peut-être alors formuler une réflexion plus globale sur la musique mixte qui, finalement, la sépare moins de la musique uniquement instrumentale et de la musique uniquement électroacoustique.

Annexes

Annexe 1 : Partition de « Il n’est plus là, je suis là »

Annexe 2 : Enregistrement de « Il n’est plus là, je suis là »

Notes

1 Pour flûte en ut et dispositif électronique, 2010. Dédiée à Geneviève Déraspe, créée au CIRMMT, Montréal, en décembre 2010.

2 Cette notation peut porter à confusion sans l’instrument : les notes en losange indiquent uniquement les doigtés, le résultat se trouve entièrement entre sol# et fa#.

3 Bien sûr, d’autres techniques compositionnelles entrent en jeu (notamment, pour cette pièce, des interpolations entre motifs mélodico-rythmiques), mais elles ne participent pas essentiellement à la constitution d’un rapport camériste entre instrument et électronique.

4 Nous considérons ici, bien sûr, la situation où il n’y a pas d’interprète direct de la partie électronique. Avec une interface appropriée (qui peut être aussi simple que des potentiomètres), cela serait équivalent à l’adaptabilité d’un instrument.

5 Ce paramètre (env_percent) correspond à combien la flûte a d’impact sur l’amplitude de la partie électronique. Les valeurs ont été fixées en répétition ; elles dépendent aussi bien du dispositif et du lieu de diffusion que des matériaux de chaque partie dans la section.

6 Il s’agit de la variable size dans le sous-patch. Encore une fois, la taille finalement utilisée a été choisie en répétition, par expérimentation. Une seule section de la pièce est concernée, le type de matériau traité était donc limité (ce qui simplifie l’expérimentation).

7 Il faut dire que dans ce dernier cas, l’artefact nous a semblé trop perceptible. Nous jugeons que ce traitement est intéressant surtout pour des fenêtres de moins de 2 secondes.