Partitions distribuées en réseau dans le cycle In memoriam Jean-Claude Risset

Jonathan Bell décembre 2020

décembre 2020DOI : https://dx.doi.org/10.56698/rfim.596

Résumés

Résumé

Le cycle de compositions In memoriam Jean-Claude Risset marque un tournant important dans l’évolution du dispositif SmartVox : initialement conçu exclusivement comme un outil d’apprentissage et de performance pour chœurs, au moyen duquel des chanteurs reçoivent leur partition et leurs audio-guides par le navigateur de leur smartphone, SmartVox est désormais employé dans des configurations plus diverses. En effet, il est utilisé pour de grands ensembles avec chœur et orchestre, en petites formations de musique de chambre (grâce à un système dédié embarqué sur Raspberry Pi), comme support pour partitions synchronisées sur casque (head-mounted display), lors de concerts participatifs en interaction avec le public ou enfin dans le contexte de production d’opéras. Cet article situe d’abord SmartVox parmi l’ensemble des technologies aujourd’hui disponibles dans le domaine de la notation musicale distribuée, puis aborde quatre compositions extraites du cycle Risset, toutes réalisées au moyen de ce dispositif (une forme de performance assistée par ordinateur sans chef d’orchestre). D’un point de vue compositionnel, ces œuvres ont été́ conçues comme des transcriptions spectrales mimétiques de sons synthétisés, en hommage au compositeur français pionnier de la synthèse sonore numérique. Par une approche « post-spectrale », cet article cherche à défendre un archétype compositionnel (le transfert mimétique d’un son naturel/synthétisé dans le domaine instrumental/vocal) que les technologies d’aujourd’hui ont rendu moins utopique.

Index

Index de mots-clés : composition algorithmique, notation musicale, partitions distribuées, réalité virtuelle et augmentée, computer music.Texte intégral

1. Mimêsis

1Si la mimêsis était un principe moteur de création artistique dans la Grèce antique, elle était certainement aussi au cœur du projet de la musique spectrale française des années 1970. Chez Tristan Murail (Murail, 2005), Gérard Grisey (Féron, 2011) ou encore dans Mortuos Plango, vivos voco de Jonathan Harvey (Whittall, 1999), l’analyse et l’imitation d’un spectre de son complexe1 font partie intégrante du processus créatif (Anderson, 2000 ; Fineberg, 2000). Si, dans cette continuité historique, on concède à l’harmonie spectrale (et donc microtonale) une valeur essentielle, il convient d’examiner comment, dans le cas de chanteurs par exemple, ce transfert mimétique peut être facilité pour reproduire des hauteurs avec précision lorsque ces derniers sont aidés par un guide-chant transmis par une oreillette (Bell, 2016, p. 4) afin d’imiter spontanément la hauteur perçue2. Le dispositif SmartVox (Bell et Matuszewski, 2017 ; Bell, 2018) consiste donc à envoyer sur les écouteurs du smartphone de chaque interprète les hauteurs (mais aussi le texte, les dynamiques, le rythme...) qu’il doit jouer et chanter, pour simplifier l’apprentissage et permettre une grande précision d’exécution, dans le domaine de l’harmonie spectrale notamment.

2Dans une composition spectrale réalisée à l’aide de SmartVox3, la notion de mimétisme apparaît de trois façons différentes : 1/ par le transfert mimétique consistant à imiter à la voix ou aux instruments un son préalablement enregistré, 2/ par l’imitation spontanée du chanteur de ce qu’il entend dans le casque – la « notation audio » (audio-score) ressemble alors beaucoup à l’effet recherché (sa réalisation par les chanteurs) : on peut alors considérer qu’elle imite plutôt qu’elle ne représente, 3/ par une approche animée de la notation musicale (le plus souvent un curseur représentant l’écoulement du temps), comme dans les stations audionumériques (digital audio workstations ou DAW), dans lesquelles le temps défile de gauche à droite, ou les tablatures piano roll.

3Pour coordonner des musiciens entre eux, et en comparaison d’approches qualifiées de mimétiques par l’auteur, la notation musicale traditionnelle requiert un long apprentissage du solfège, de la justesse, du système rythmique, ainsi que du système de direction (ajustement entre l’écrit et la gestuelle du chef, lorsque la pièce est dirigée).

2. Notation

2.1. Expérimentation en notation musicale : contexte international

4Le site animatednotation.com de Ryan Ross Smith (Smith, 2015 ; Smith, 2016) montre qu’aujourd’hui de nombreux compositeurs cherchent une alternative à cette pratique traditionnelle. Bien que, dès l’an 2000, on puisse tracer de nombreux témoignages de notation temps réel (Clay et Freeman, 2010, p. 1 ; Fober, Orlarey et Letz, 2012), ou encore de notation distribuée (Fober et al., 2015 ; Celerier, Desainte-Catherine et Couturier, 2017), la conférence Tenor4, qui existe depuis 2015, apparaît comme le lieu privilégié de ces questionnements. Majoritairement australiens, plusieurs des compositeurs/chercheurs qui y participent se fédèrent sur le concept de screen-scores, attribué à (Hope et Vickery, 2011). Comme le faisait déjà Mauricio Kagel dans Prima Vista (1962-1964), la notation animée est souvent projetée sur un grand écran, sur lequel chaque musicien identifie sa partie5. La partition se trouve dans le champ de vision des interprètes mais aussi du public, faisant de la notation une partie intégrante de la performance théâtrale.

5De nombreux systèmes, plus axés sur la performance que sur la composition (le paradigme du « score player » : SmartVox (Bell et Matuszewski, 2017 ; Bell, 2018), INScore (Fober et al., 2015), Zscore (Zagorac, 2018), Decibel (Hope, Wyatt et Thorpe, 2018 ; Hope et al., 2015), Maxscore (Hajdu et Didkovsky, 2018), Comprovisador (Louzeiro, 2018), dn-m (Bean, 2015) s’efforcent de distribuer et de synchroniser chaque partie séparée de la partition sur les périphériques des musiciens (smartphones, tablettes ou ordinateurs portables). Avec SmartVox par exemple, le rendu de la partition dans le navigateur s’est révélé très efficace pour ce type de configuration. Grâce aux technologies web multiplateformes, l’application fonctionne avec n’importe quel appareil doté d’un navigateur web et aucune installation n’est donc requise par le client. L’architecture node.js6/WebSocket de SmartVox, nous l’espérons, inspirera de plus en plus de compositeurs, interprètes, chercheurs et développeurs à explorer cette pratique musicale émergente de la notation distribuée.

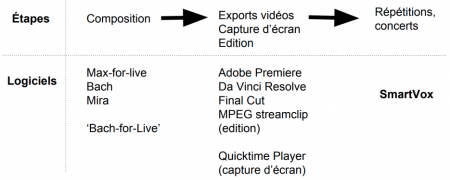

2.2. Notation graphique dans bach

6La plupart des œuvres réalisées avec SmartVox reposent en grande partie sur bach7 (Agostini et Ghisi, 2012) pour le processus de composition. Chaque partition audio-visuelle est ensuite filmée sous forme de capture d’écran, puis envoyée et synchronisée via SmartVox8, comme l’exprime la Figure 1 :

Figure 1. De la composition dans bach à l’export vers SmartVox

Source : Jonathan Bell, 2019

7L’utilisation de couleurs et de formes dans des pièces comme In memoriam Jean-Claude Risset I ou Mit Allen Augen (In memoriam Jean-Claude Risset 2) est inspirée par Cat Hope (Hope, 2017 ; Hope et al., 2015) et Lyndsey Vickery (Vickery, 2018), les développeurs de Decibel ScorePlayer, dont l’approche de la notation graphique animée ouvre de nouvelles perspectives compositionnelles.

8Contrairement à d’autres objets dédiés à la notation dans Max, comme MaxScore (Hajdu et Didkovsky, 2018) ou Symbolist (Gottfried et Bresson, 2018) imaginés sous forme de représentations graphiques/symboliques9, l’environnement bach prend racine dans OpenMusic (Bresson, Agon, et Assayag, 2011) et la composition assistée par ordinateur, ce qui explique certaines de ses limites d’un point de vue graphique : à l’inverse de MaxScore par exemple, il est impossible d’insérer une image dans un objet bach.roll10. Ce dernier ne supportait pas non plus les articulations jusqu’à la version 0.8.1 (contrairement à l’objet bach.score11 en notation rythmique mesurée12). En dépit de ces quelques limitations graphiques, l’un des points forts de bach réside dans sa capacité́ à contrôler directement des synthétiseurs à partir de la notation. Au moyen des slots, chaque note peut contenir des métadonnées ou des automations temporelles destinées à être mappées sur n’importe quel sampler/synthétiseur programmé par Max, permettant ainsi de manipuler les portées d’une partition comme les pistes d’une station audionumérique13.

2.3. Notation musicale distribuée

9Plusieurs chercheurs et compositeurs reconnaissent aujourd’hui l’analogie qui peut être établie entre la pratique de notation musicale traditionnelle (du conducteur et des parties séparées) et celle des architectures distribuées – ou systèmes répartis (Celerier, Desainte-Catherine et Couturier, 2017) – dans les applications web dédiées à la notation – Zscore (Zagorac et Alessandrini, 2018), MASD (Magnus et Gerhard, 2012) et SmartVox (Bell et Matuszewski, 2017), dans lesquelles plusieurs clients coordonnent leurs actions en passant des messages les uns aux autres. La conférence Tenor 2018 à Montréal a souligné pour l’auteur une proximité entre Decibel Score-Player et SmartVox, dans le sens où ces deux logiciels sont des solutions plutôt élémentaires convergeant toutes deux vers le paradigme axé sur la performance de l’instrumentiste, tandis que d’autres environnements de notation (bach, MaxScore, Symbolist…) sont plus orientés vers des processus de composition en temps réel. Bien que Decibel ScorePlayer soit la solution d’application iOS la plus fiable aujourd’hui pour la notation animée distribuée, Cat Hope et Aaron Wyatt ont évoqué la possibilité de migrer leur système vers le navigateur, suite aux difficultés de réseau rencontrées avec l’application native, mais aussi en vue d’un accès instantané via Internet et d’un coût de production amoindri (pour des projets impliquant plus de cinquante appareils, l’iPad devient une solution très onéreuse). L’architecture la plus susceptible de permettre ce transfert de technologie serait un serveur node.js (server-side Javascript) avec le protocole de communication WebSocket, une solution utilisée par SmartVox dès 2015, grâce à Norbert Schnell et Benjamin Matuszewski (Ircam, Paris). Le serveur SmartVox envoie et synchronise des partitions audiovisuelles au format mp4, ce qui ce qui s’est révélé être d’une efficacité indéniable lors de concerts et de répétitions impliquant de nombreux participants, mais comportant également la faiblesse potentielle d’une solution « en temps différé », dont l’interprétation est à chaque fois identique. D’autres compositeurs/chercheurs (Georg Hajdu, Rama Gottfried et Slavko Zagorac) étudient actuellement des solutions plus flexibles permettant de contrôler du contenu graphique SVG (scalable vector graphic) directement sur la page HTML côté client. L’architecture choisie à cet effet par Georg Hajdu et Rama Gottfried est node.js, qui envoie des donnés de contrôle par OSC (open sound control), via WebSockets. Ce projet a abouti à une pièce pour 144 parties distribuées en temps réel à Hambourg en mai 2019.

2.4. Notation distribuée en head-mounted display

10In memoriam Jean-Claude Risset 114, créée en septembre 2018 au festival Gaudeamus Muziekweek (Utrecht), constitue la première tentative de l’auteur d’utiliser des head-mounted displays (affichages frontaux) : il s’agissait de smartphones portés sur des casques, approchant ainsi une situation de réalité augmentée (augmented reality). Ces casques, utilisés pour la flûte et la clarinette, ont révélé des potentiels intéressants et furent exploités à plus large échelle dans Mit Allen Augen (In memoriam Jean-Claude Risset 2). Dans la même lignée, Common Ground15, une pièce plus récente, est composée d’une polyphonie élaborée à partir de sons synthétisés dans le Synthesis ToolKit, via la librairie Percolate dans Max/MSP (Cook et Scavone, 1999), avec une chorégraphie réalisée dans INScore [14]. Deliciae16, enfin, explore la synthèse sonore avec une interface en réalité virtuelle (virtual reality) via PatchXR (anciennement Mux), contrôlant un patch Max/MSP par OSC (Andersson, Erkut et Serafin, 2019).

11Tout comme des partitions traditionnelles placées sur un pupitre, les screen scores, affichés sur tablette (pour les instrumentistes) ou sur téléphone (pour les chanteurs), obligent les interprètes à regarder et à se positionner constamment en direction de la partition. Cette convention bien établie dans la configuration de concert classique limite considérablement les possibilités de mise en scène de la musique, dans un contexte plus général de représentation/performance.

12Dans la version de Vortex Temporum de Gérard Grisey interprétée par l’Ensemble Ictus et chorégraphiée par Anne Teresa De Keersmaeker17, par exemple, les musiciens se sont trouvés contraints de maîtriser de mémoire la partition, tout en l’exécutant sans chef d’orchestre. Dans ce type de situation, des head-mounted displays, synchronisés par Wi-Fi, pourraient constituer un moyen intéressant d’aider les musiciens à se coordonner dans le temps et dans l’espace, lors de leurs déplacements sur scène ou autour du public, sans pour autant les mettre dans une situation délicate lors de représentations.

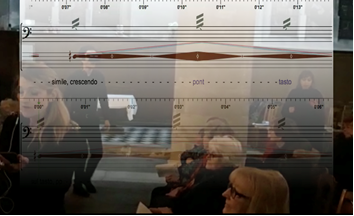

13Selon les interprètes, ces casques offrent un affichage large et confortable, car l’environnement est toujours visible autour de la partition (voir Figure 2) ou à travers la partition, dans le cas d’un affichage holographique18. Cet investissement physique des interprètes n’est pas sans rappeler le terme phygital (physique + digital : Lupetti, Piumatti et Rossetto, 2015), selon lequel les possibilités de physicalisation du jeu vidéo engloberont bientôt d’autres domaines de réalité augmentée et virtuelle.

Figure 2. Représentation de la partition du point de vue de l’interprète, dans la pièce Mit Allen Augen

Source : Jonathan Bell, In memoriam Jean-Claude Risset 2 Mit Allen Augen, 2018, dans l’environnement bach (crédits image : Jonathan Bell)

14En attendant des solutions plus discrètes (telles que des lunettes Vufine19, qui seraient presque invisibles du public), ou encore des systèmes de réalité augmentée (Kim-Boyle, 2019), ces casques head-mounted display ouvrent déjà des pistes de recherche, qui pourraient aller au-delà du simple affichage de la notation animée. L’Australie compte aujourd’hui la plus grande communauté de compositeurs/chercheurs au monde travaillant dans la notation animée et des compositeurs australiens tels que Benedict Carey et David Kim-Boyle (voir leurs articles respectifs de 2016 et 2017), qui étudient spécifiquement les partitions 3D dans des environnements de réalité virtuelle, devraient apporter rapidement des éléments de réponse à cette question.

3. Networked music performances (NMPs)

3.1. Distribution de partitions sur le Web et NMPs distantes

15Avec la croissance exponentielle du Web, l’hébergement de SmartVox20 sur Internet (c’est-à-dire sur un serveur distant plutôt que local) est apparu comme une nécessité. Cependant, nous avons démontré (au chapitre 4.2 « Measurements of timing accuracy » de la contribution à la conférence Tenor 2018 – Bell, 2018, p. 17-23) que, même si la synchronisation des différentes pièces était assez précise de cette manière, les solutions locales restent plus sures (dans la même pièce, par Wi-Fi). En outre, bien que SmartVox appartienne incontestablement au domaine des performances musicales en réseau (networked music performances ou NPMs), il est devenu clair que son application pratique relève de la sous-catégorie des NMP « locales » définie par Leonardo Gabrielli et Stefano Squartini (Gabrielli et Squartini, 2016), dans lesquelles les musiciens interagissent dans le même espace physique.

16Depuis l’avènement d’Internet, des recherches approfondies ont été menées dans le domaine des performances musicales en réseau à distance, ou NMP « distantes » (Rottondi et al., 2016). Aujourd’hui, cependant, les NMP « locales » semblent toujours plus viables, tant d’un point de vue technique qu’artistique. Alors que les jeunes générations tendent à jouer à des jeux vidéo en ligne (c’est-à-dire à distance), à travers des avatars, avec leurs amis ou des joueurs anonymes souvent situés aux quatre coins du monde, peu d’exemples contrediront le fait que les musiciens sont encore aujourd’hui plutôt enclins à lire une partition ou à improviser ensemble physiquement (c’est à dire dans un même lieu), probablement à cause du rapport geste/son intrinsèque à toute interaction en musique de chambre. Dans Embodiment and disembodiment in networked music performance (Hajdu, 2017), Georg Hajdu explique que « l’appréciation [de l’expérience musicale] repose sur la plausibilité́ entre action physique et résultat sonore ». Depuis l’émergence des NMPs21, le public et les musiciens ont souvent exprimé une certaine déception, car dans de telles situations, pour le spectateur, très peu est donné à voir et donc à comprendre. Cela est aggravé pour les interprètes distants : « En raison de l’éloignement des participants, ces actions peuvent ne pas toujours être perçues directement ou immédiatement […], les relations classiques de cause à effet […] sont remplacées par la vraisemblance, c’est-à-dire la mesure dans laquelle les artistes interprètes et les spectateurs sont capables de croire au résultat d’une performance en construisant une carte mentale de l’interaction. Dans les NMPs, ceci peut être facilité par l’utilisation d’avatars, de visuels projetés et de dramaturgies soigneusement orchestrées, impliquant des participants dans des scénarios de jeu22 ». Aujourd’hui, de nombreux environnements de réalité virtuelle se concentrent sur cette interaction entre une action physique et son résultat sonore. New Atlantis (Sinclair et al., 2017), par exemple, est une plateforme d’exploration sonore multi-utilisateurs dans laquelle plusieurs joueurs peuvent interagir23. Grâce à leur capacité à représenter les avatars des interprètes musicaux, ces nouvelles interfaces pourraient bientôt permettre de recréer l’entité visuelle produisant le son (ou la musique). En recréant des liens de causalité virtuels entre une action et son résultat sonore, ces interfaces de jeu en ligne devraient fournir aux utilisateurs l’élément visuel manquant, qui empêche encore aujourd’hui les NMPs de devenir une véritable pratique musicale mondialisée.

3.2. Système embarqué sur Raspberry Pi pour NMPs locales (BabelBox)

17L’auteur a démontré que SmartVox convient à des projets de grande envergure, tels que Le Temps des nuages24, dans lequel quatre-vingts chanteurs et musiciens ont synchronisé leurs partitions par le même réseau (Bell, 2018). Ces productions suscitent un intérêt croissant de la part des chorales et des ensembles25 et nécessitent une configuration technique très modeste (un seul point d’accès Wi-Fi, comme par exemple une borne Ubiquiti Unifi) pour les chœurs jusqu’à trente chanteurs, avec un serveur node.js fonctionnant sur un ordinateur (macOS ou Linux). Cependant, dans le contexte plus intime de la musique de chambre (comme dans In memoriam Jean-Claude Risset 1), l’objectif est différent : la charge du réseau est beaucoup moins importante, ce qui a incité à trouver une solution minimale pour permettre des répétitions sans difficultés d’installation (pour pouvoir se passer de la présence physique du compositeur ou de la mobilisation d’un technicien uniquement pour configurer un réseau). L’installation à distance du serveur sur l’ordinateur de l’interprète (les chefs de chœurs, le plus souvent) a été possible dans le cas de SmartVox ou Mit Allen Augen, même avec des musiciens non familiarisés avec la technologie, grâce à la souplesse du Node Package Manager (NPM), qui réduit l’installation de SmartVox à quelques lignes de commande26. Ce processus d’installation est néanmoins resté un obstacle à la diffusion de SmartVox. À la recherche d’un système dédié léger, plug and play, à envoyer par la poste, le nano-ordinateur Raspberry Pi est alors rapidement apparu comme la meilleure option pour héberger SmartVox sur un système embarqué. Node.js fonctionne sur Raspbian et SmartVox s’est avéré être très stable sur un Raspberry Pi 3. Ainsi, une fois installé, les deux seules étapes d’un outil plug and play livrable aux interprètes sans configuration étaient :

-

de démarrer SmartVox au démarrage au moyen d’un service (dans systemd), exécutant le script de lancement du serveur après initialisation du système ;

-

de configurer une adresse statique pour un routeur dédié (par exemple TP-Link…).

18Ce système peu couteux (moins de 65 € pour un ordinateur Raspberry et un routeur) permet désormais l’envoi de partitions prêtes à l’emploi. Une fois le système branché au secteur, tout ce que les utilisateurs doivent faire est de se connecter au Wi-Fi dédié et de taper l’adresse IP statique du serveur sur leur smartphone/tablette (par exemple, pour les utilisateurs : 192.168.0.2:8000 et pour le conducteur : 192.168.0.2:8000/conductor). Ce dispositif a notamment été utilisé en Australie dans la pièce Common Ground (Bell et Wyatt, 2020).

4. Orchestration mimétique

19À l’exception du premier opus (In memoriam Jean-Claude Risset 1), dont les hauteurs proviennent de l’analyse des spectres de synthèse FM, toutes les pièces du cycle se basent sur une orchestration mimétique27 du synthétiseur du laboratoire Prism développé par Richard Kronland-Martinet (Conan et al., 2014), qui a longtemps travaillé avec Jean-Claude Risset au laboratoire de Mécanique et d’acoustique de Marseille. Ce synthétiseur est basé sur un modèle perceptif – complémentaire d’une approche par modèle physique (Ellis, Bensoam et Caussé, 2005) – et porte l’influence de l’exploration de la synthèse du timbre par Risset, examinée sous l’angle de la perception humaine (Risset et Wessel, 1999). La grande majorité de l’électronique des pièces de ce cycle (In memoriam Jean-Claude Risset 2, 3 et 4) utilise le paramètre de liquéfaction, qui transforme un son continu en petits grains évoquant les impacts retentissants des gouttes sur des surfaces métalliques résonnantes, ou une forme de pluie imaginaire sur des carillons métalliques28. La librairie bach a encore une fois été très utile pour la transcription musicale, permettant par la suite un transfert dans le domaine instrumental. Ces pièces reposent donc majoritairement sur le procédé spectral consistant à analyser, transcrire, puis orchestrer l’évolution spectrale/temporelle d’une trame électroacoustique.

20Les scènes de musique contemporaine, telles que celles représentées en Europe par les académies et festivals de Gaudeamus ou Darmstadt, révèlent cependant que ces préoccupations spectrales sont souvent très éloignées de ce que les jeunes générations de compositeurs souhaitent exprimer. Il convient par conséquent de qualifier de néo ou de post-spectrales les techniques ici considérées. Bien que ce canon esthétique soit encore enseigné dans des institutions telles que l’Ircam, ou souvent (mais brièvement) mentionné dans les programmes d’enseignement de composition, on peut déplorer le fait qu’il ait vu le jour avant que les avancées technologiques puissent proposer des interfaces plus intuitives pour les compositeurs (telles que les outils présents dans ce document : thank, Ableton, synthétiseur Prism), ou une assistance auditive et visuelle pour les interprètes (SmartVox). De tels outils, aujourd’hui accessibles de tous, permettraient de réaliser de façon beaucoup plus automatisée le mariage entre sons instrumentaux et électroniques rêvé par les premiers compositeurs spectraux.

4.1. Domaine temporel : précision temporelle et transfert mimétique

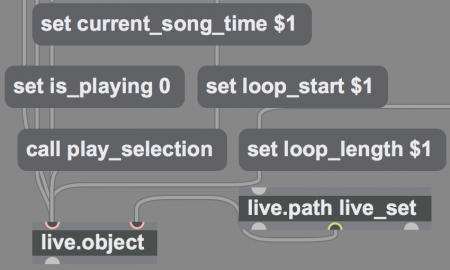

21En 2018, à l’Ircam, Benjamin Matuszewski a amélioré de façon substantielle les possibilités de synchronisation de SmartVox en implémentant un algorithme côté client capable de rétablir la synchronisation des périphériques dont la dérive dépasse un certain seuil (Bell, 2018, chapitre 4.3). Avant cette nouvelle version, les utilisateurs de SmartVox devaient faire face à une temporalité plus approximative. Ils peuvent maintenant explorer un large éventail de situations musicales étroitement synchronisées, entre musiciens, électronique et vidéo, par exemple. L’objet bach.roll (un éditeur en notation proportionnelle) envoie quant à lui des notifications de son état de lecture en temps réel. Ces notifications peuvent être interprétées dans Max for Live afin de synchroniser la notation pour les joueurs humains dans bach, ainsi que l’électronique dans Ableton Live. La Figure 3 montre comment accéder aux commandes de lecture d’Ableton par live-set path depuis le live object model (LOM), ce qui permet une synchronisation constante entre la partition et l’électronique, pendant le processus de composition. Ce dialogue inter-application a largement facilité le processus compositionnel de Mit Allen Augen, In memoriam Jean-Claude Risset 2, une pièce pour 12 voix, 12 instruments et électronique donnée à Paris en mars 201929.

Figure 3. Device Max for Live synchronisant bach et Ableton

Source : Max for Live, environnement bach et Ableton Live (crédits image : Jonathan Bell, 2019)

22Les pièces du cycle Risset bénéficient toutes de la souplesse que permet ce dialogue entre bach et Ableton : dans la première pièce du cycle par exemple, un passage explore des jeux de hoquets, dont la précision rythmique tire parti de l’affichage du temps sous forme de curseur déroulant30. Dans Das Hoheslied, In memoriam Jean-Claude Risset 331, les étudiants de la Hochschule für Musik und Theater Hamburg ont pu, lors d’un tout premier déchiffrage, chanter des passages qui ressemblaient de manière frappante au modèle visé.

4.2. Domaine fréquentiel : analyse harmonique de synthèse FM

23Plutôt que de citer l’illusion du célèbre glissando Shepard-Risset, l’auteur a jugé plus approprié de réactiver l’une des techniques les plus prisées des débuts de l’informatique musicale : la modulation de fréquence, dont Jean-Claude Risset fut l’un des premiers utilisateurs (dans son œuvre Mutations, en 1969, grâce à la généreuse permission de John Chowning). C’est pourquoi presque tout le matériel harmonique de In memoriam Jean-Claude Risset 1 et 3 a été généré par synthèse FM. Pour l’analyse de fréquence, bien que Iana (Todoroff, Daubresse et Fineberg, 1995) ait déjà été utilisé (et également favorisé par les développeurs de bach (Agostini et Ghisi, 2012) dans certains algorithmes de transcription), le descripteur de l’Ircam zsa.freqpeak (Malt et Jourdan, 2008) offrait des résultats plus précis. Zsa.freqpeak a donc été utilisé dans un device Max for Live pour la visualisation des hauteurs. Inspirée par les conclusions de Risset concernant l’évolution temporelle du contenu harmonique des sons de trompette enregistrés numériquement – qui s’enrichit dans l’aigu lorsque la loudness augmente (Risset, 1965) –, la disposition de l’écriture chorale d’un court passage de la pièce32 imite l’indice de modulation de fréquence et son évolution temporelle, en entrées successives de voix, du registre le plus grave (basses) vers l’aigu (soprani).

4.3. Spectralisme mimétique et imitation vocale, conclusion et prolongements

24Certains des outils présents dans ce chapitre montrent que les possibilités offertes par les technologies actuelles auraient séduit les partisans du « spectralisme mimétique » des années 1970. Dans un contexte plus expérimental, le laboratoire Prism33 a entrepris une étude de l’imitation vocale qui rappelle l’expérience de lecture à vue de Das Hoheslied. Thomas Bordonné explique que cette étude « visait à déterminer les caractéristiques principales des sons (inconsciemment) choisis par les participants lors d’imitations vocales ». Il conclut : « Les imitations vocales semblent être un bon outil pour accéder à la perception et déterminer quels paramètres du sonore sont les plus significatifs » (Bordonné et al., 2017). Dans cette étude expérimentale, par conséquent, tout comme dans les séances de déchiffrage organisées autour de SmartVox, les participants/chanteurs sont invités à imiter ce qu’ils entendent.

Conclusion

25Initialement conçu presque exclusivement comme un outil de répétition dans le cadre de pratiques chorales (Bell Matuszewski, 2017), de récentes utilisations montrent que SmartVox se définit surtout comme un lecteur (media player) de partitions distribuées (au format mp4) convenant aussi bien aux instrumentistes qu’aux chanteurs de tous niveaux (des premières classes de solfège aux professionnels spécialisés dans l’opéra et/ou la création contemporaine). Comme aide à l’intonation, SmartVox est particulièrement adapté aux procédés hérités de la musique spectrale. Les améliorations récentes concernent 1/ les capacités de synchronisation du dispositif, 2/ son embarquement sur Raspberry Pi, facilitant sa dissémination par BabelScore, et 3/ une première série d’expérimentations de head-mounted display, s’approchant de situations de réalité augmentée. Si la notation reste un concept clé pour SmartVox, la notion de performance musicale en réseau (networked musical performance) la définit encore mieux.

Remerciements

26J’aimerais remercier Andrea Agostini, Daniele Ghisi, Georg Hajdu, Richard Kronland-Martinet, Benjamin Matuszewski, Norbert Schnell et l’ensemble De Caelis pour leur soutien.

Bibliographie

Agostini Andrea et Ghisi Daniele (2012), « bach: an environment for computer-aided composition in Max », in Proceedings of the 38th International Computer Music Conference (ICMC), Ljubljana, 9-14 septembre, p. 373-378.

Anderson Julian (2000), « A provisional history of spectral music », Contemporary Music Review [en ligne], vol. 19, no 2, p. 7-22. DOI : https://doi.org/10.1080/07494460000640231

Andersson Nikolaj, Erkut Cumhur et Serafin Stefania (2019), « Immersive audio programming in a virtual reality sandbox », in Tony Tew et Duncan Williams (dir.), 2019 AES International Conference on Immersive and Interactive Audio, York, 27-29 mars, New York, Audio Engineering Society.

Bean James (2015), « Denm (dynamic environmental notation for music): introducing a performance-centric musical interface », in Marc Battier et al. (dir.), Proceedings of the First International Conference on Technologies for Music Notation and Representation, Paris, Institut de recherche en musicologie, p. 74-80.

Bell Jonathan (2016), « Audio-scores, a resource for composition and computer-aided performance » [en ligne], thèse de doctorat en musique, sous la direction de James Weeks, Guildhall School of Music and Drama. URL : http://openaccess.city.ac.uk/17285/ [consulté le 15/11/2020]

Bell Jonathan (2018), « Audiovisual scores and parts synchronized over the Web » [en ligne], in Sandeep Bhagwati et Jean Bresson (dir.), Proceedings of the Fourth International Conference on Technologies for Music Notation and Representation, 24-26 mai, Montréal, Université Concordia, p. 17-23. URL : https://hal.archives-ouvertes.fr/hal-01779806

Bell Jonathan (2019), « Animated notation, score distribution, and AR-VR environments for spectral mimetic transfer in music composition » [en ligne], in Sandeep Bhagwati et Jean Bresson (dir.), Proceedings of the Fifth International Conference on Technologies for Music Notation and Representation, Melbourne, Monash University, p. 17-23. URL : https://www.tenor-conference.org/proceedings/2019/01Bell.pdf

Bell Jonathan et Matuszewski Benjamin (2017), « SmartVox, a web-based distributed media player as notation tool for choral practices », in Helena Lopez Palma et al. (dir.), Proceedings of the Third International Conference on Technologies for Music Notation and Representation, 24-26 mai, La Corogne, Université de La Corogne, p. 99-104.

Bell Jonathan et Wyatt Aaron (2020), « Music and dance directed by a Raspberry Pi », in Richard Hoadley, Dominique Fober et Chris Nash (dir.), Proceedings of the Sixth International Conference on Technologies for Music Notation and Representation, Melbourne, Monash University

Bordonné Thomas et al. (2017), « Assessing sound perception through vocal imitations of sounds that evoke movements and materials », in Mitsuko Aramaki et al. (dir.), Music Technology with Swing: 13th International Symposium, CMMR 2017, Matosinhos, 25-28 septembre, Cham, Springer, p. 402-412. URL : https://hal.archives-ouvertes.fr/hal-01810880 ; DOI : https://doi.org/10.1007/978-3-030-01692-0_26

Bresson Jean, Agon Carlos et Assayag Gérard (2011), « Open-Music: visual programming environment for music composition, analysis and research », in Proceedings of the 19th ACM international conference on MultiMedia (MM’11), Scottsdale, 28 novembre-1 décembre, p. 743-746. URL : https://hal.archives-ouvertes.fr/hal-01182394 ; DOI : https://doi.org/10.1145/2072298.2072434

Carey Benedict (2016), « Spectrascore VR: Networkable virtual reality software tools for real-time composition and performance », in Proceedings of the International Conference on New Interfaces for Musical Expression, Brisbane, Queensland Conservatorium, p. 3-4. DOI : http://doi.org/10.5281/zenodo.1176004

Celerier Jean-Michaël, Desainte-Catherine Myriam et Couturier Jean-Michel (2017), « Exécution répartie de scénarios interactifs », in Pierre Couprie et al. (dir.), Actes des Journées d’Informatique Musicale 2017, musée de la Musique, 17-20 mai, Paris, Collegium Musicæ. URL : https://hal.archives-ouvertes.fr/hal-02491181

Clay Arthur et Jason Freeman (2010), « Preface: virtual scores and real-time playing », Contemporary Music Review [en ligne], vol. 29, no 1, p. 1. DOI : https://doi.org/10.1080/07494467.2010.509587

Conan Simon et al. (2014), « An intuitive synthesizer of continuous-interaction sounds: rubbing, scratching, and rolling », Computer Music Journal, vol. 38, no 4, p. 24-37.

Cook Perry et Scavone Gary (1999), « The Synthesis ToolKit (STK) », in Joseph Fung, Proceedings of the 1999 International Computer Music Conference, Pékin, 22-27 octobre, p 164, San Francisco, International Computer Music Association. URL : https://quod.lib.umich.edu/i/icmc/bbp2372.1999.366/--synthesis-toolkit-stk?view=image [consulté le 15/11/2020]

Ellis Nicholas, Bensoam Joël et Causse René (2005), « Modalys demonstration », in Proceedings of the 2005 International Computer Music Conference, Barcelone, 4-10 septembre, p. 101-102. URL : https://hal.archives-ouvertes.fr/hal-01161344

Féron François-Xavier (2011), « The emergence of spectra in Gérard Grisey’s compositional process: from Dérives (1973-74) to Les espaces acoustiques (1974-85) », Contemporary Music Review [en ligne], vol. 30, no 5, p. 343-375. DOI : https://doi.org/10.1080/07494467.2011.665582

Fineberg Joshua (2000), « Spectral music », Contemporary Music Review [en ligne], vol. 19, no 2, p. 1-5. DOI : https://doi.org/10.1080/07494460000640221

Fober Dominique, Orlarey Yann et Letz Stéphane (2012), « INScore: an environment for the design of live music scores », in Frank Neumann et Fernando Lopez-Lezcano (dir.), Proceedings of the Linux Audio Conference 2012 [en ligne], Stanford, Université Stanford, 12-15 avril, Center for computer research in music and acoustics, p. 47-54. URL : http://lac.linuxaudio.org/2012/papers/12.pdf [consulté le 15/11/2020]

Fober Dominique et al. (2015), « Distributing music scores to mobile platforms and to the internet using INScore », in Joseph Timoney et Thomas Lysaght (dir.), Proceedings of the 12th International Conference on Sound and Music Computing [en ligne], 30 juillet-1 août, Maynooth, Université nationale d’Irlande, p. 229-233. DOI : https://doi.org/10.5281/zenodo.851061

Gabrielli Leonardo et Squartini Stefano, Wireless Networked Music Performance [en ligne], Singapour, Springer Singapore, 2016, p. 53-92. DOI : https://doi.org/10.1007/978-981-10-0335-6₅

Gottfried Rama et Bresson Jean (2018), « Symbolist: an open authoring environment for user-defined symbolic notation », in Sandeep Bhagwati et Jean Bresson (dir.), Proceedings of the Fourth International Conference on Technologies for Music Notation and Representation, 24-26 mai, Montréal, Université Concordia, p. 111-118.

Hajdu Georg et al. (2010), « Notation in the context of Quintet.net projects », Contemporary Music Review [en ligne], vol. 29, no 1, p. 39-53. DOI : https://doi.org/10.1080/07494467.2010.509592

Hajdu Georg (2017), « Embodiment and disembodiment in networked music performance », in Clemens Wöllner (dir.), Body, Sound and Space in Music and Beyond: Multimodal Explorations, Abingdon, Routledge, coll. « Sempre », p. 257-278.

Hajdu Georg et Didkovsky Nick (2018), « Maxscore: Recent developments », in Sandeep Bhagwati et Jean Bresson (dir.), Proceedings of the Fourth International Conference on Technologies for Music Notation and Representation, 24-26 mai, Montréal, Université Concordia, p. 138-146.

Hope Cat et Vickery Lindsay (2011), « Screen scores: new media music manuscripts », in Proceedings of the 2011 International Computer Music Conference [en ligne], Université de Huddersfield, 31 juillet-5 août, San Francisco, International Computer Music Association, Huddersfield, Centre for Research in New Music, p. 224-230. URL : http://hdl.handle.net/2027/spo.bbp2372.2011.045 [consulté le 15/11/2020]

Hope Cat et al. (2015), « The decibel scoreplayer: a digital tool for reading graphic notation », in Marc Battier et al. (dir.), Proceedings of the First International Conference on Technologies for Music Notation and Representation, Paris, Institut de recherche en musicologie, p. 58-69.

Hope Cat (2017), « Electronic scores for music: the possibilities of animated notation », Computer Music Journal [en ligne], vol. 41, no 3, p. 21-35.

Hope Cat, Wyatt Aaron et Thorpe Daniel (2018), « Scoring an animated notation opera: the decibel score player and the role of the digital copyist in “speechless” », in Sandeep Bhagwati et Jean Bresson (dir.), Proceedings of the Fourth International Conference on Technologies for Music Notation and Representation, 24-26 mai, Montréal, Université Concordia, p. 193-200.

Kim-Boyle David (2017), « The 3-D score », in Helena Lopez Palma et al. (dir.), Proceedings of the Third International Conference on Technologies for Music Notation and Representation, 24-26 mai, La Corogne, Université de La Corogne, p. 33-38.

Kim-Boyle David (2019), « 3D notations and the immersive score », Leonardo Music Journal, vol. 29, p. 39-41

Kim-Boyle David and Carey Benedict (2019), « 3D scores on the hololens », in Cat Hope, Lindsay Vickery et Nat Grant (dir.), Proceedings of the Fifth International Conference on Technologies for Music Notation and Representation, Melbourne, Monash University, 23-27 juillet, p. 1-6. https://www.tenor-conference.org/proceedings/2019/08Kim-Boyle.pdf

Lepetit-Aimon Gabriel et al. (2016), « Composition de partitions symboliques dans inscore », in Actes des Journées d’Informatique Musicale JIM’16, Albi, 31 mars-2 avril, p. 54-60. URL : http://jim2016.gmea.net/medias/JIM2016_Actes.pdf [consulté le 15/11/2020]

Louzeiro Pedro (2018), « Improving sight-reading skills through dynamic notation – the case of comprovisador », in Sandeep Bhagwati et Jean Bresson (dir.), Proceedings of the Fourth International Conference on Technologies for Music Notation and Representation, 24-26 mai, Montréal, Université Concordia, p. 55-61.

Lupetti Maria L., Piumatti Giovanni et Rossetto Frederica (2015), « Phygital play HRI in a new gaming scenario », in 2015 7th International Conference on Intelligent Technologies for Interactive Entertainment (INTETAIN), Turin, 10-12 juin, p. 17-21.

Magnus Nathan et Gerhard David (2012), « Musician assistance and score distribution (MASD) », in Georg Essl et al. (dir.), Proceedings of The International Conference on New Interfaces for Musical Expression, 21-23 mai, Ann Arbor, University of Michigan. DOI : http://doi.org/10.5281/zenodo.1178337

Malt Mikhail et Jourdan Emmanuel (2008), « Zsa.Descriptors: a library for real-time descriptors analysis », in Martin Supper et Stefan Weinzierl (dir.), 5th Sound and Music Computing Conference: sound in space – space in sound [en ligne], Université technique de Berlin, 31 juillet-3 août, Berlin, Presses de l’université technique de Berlin, p. 134-137. URL : https://hal.archives-ouvertes.fr/hal-01580326

Murail Tristan (2005), « The revolution of complex sounds », Contemporary Music Review [en ligne], vol. 24, no 2-3, p. 121-135. DOI : https://doi.org/10.1080/07494460500154780

Risset Jean-Claude (1965), « Computer study of trumpet tones », The Journal of the Acoustical Society of America [en ligne], vol. 38, no 5, p. 912. DOI : https://doi.org/10.1121/1.1939648

Risset Jean-Claude et Wessel David (1999), « Exploration of timbre by analysis and synthesis » [en ligne], in Diana Deutsch (dir.), The Psychology of Music, Academic Press, 1999, p. 113-169. URL : https://hal.archives-ouvertes.fr/hal-00939432 ; DOI : https://doi.org/10.1016/B978-012213564-4/50006-8

Rottondi Cristina et al. (2016), « An overview on networked music performance technologies », IEEE Access, vol. 4, p. 8823-8843.

Schnell Norbert et Robaszkiewicz Sébastien (2015), « Soundworks: a playground for artists and developers to create collaborative mobile web performances », in Proceedings of the first Web Audio Conference (WAC), Ircam, 26-28 janvier.

Sinclair Peter et al. (2017), « New Atlantis: audio experimentation in a shared online world », in Mitsuko Aramaki, Richard Kronland-Martinet et Sølvi Ystad (dir.), Bridging People and Sound. 12th International Symposium, CMMR 2016 [en ligne], São Paulo, 5-8 juillet 2016, Cham, Springer, coll. « Lecture Notes in Computer Science », p. 229-246. URL : https://hal.archives-ouvertes.fr/hal-01791975 ; DOI : https://doi.org/10.1007/978-3-319-67738-5_14

Smith Ryan Ross (2015), « An atomic approach to animated music notation », in Marc Battier et al. (dir.), Proceedings of the First International Conference on Technologies for Music Notation and Representation, Paris, Institut de recherche en musicologie, p. 40-48. URL : https://www.tenor-conference.org/proceedings/2015/06-RossSmith-AtomicAMN.pdf [consulté le 15/11/2020]

Smith Ryan Ross (2016), « [Study no. 50][notational becoming][speculations] », in Richard Hoadley, Dominique Fober et Chris Nash (dir.), Proceedings of the Second International Conference on Technologies for Music Notation and Representation, Cambridge, Anglia Ruskin University, p. 98-104. URL : https://www.tenor-conference.org/proceedings/2016/14_Ross-Smith_tenor2016.pdf [consulté le 15/11/2020]

Todoroff Todor, Daubresse Éric et Fineberg Joshua (1995), « IANA: a real-time environment for analysis and extraction of frequency components of complex orchestral sounds and its application within a musical realization », in Rick Bidlack (dir.), Proceedings of the 1995 International Computer Music Conference [en ligne], Centre des arts de Banff, 3-7 septembre, San Francisco, International Computer Music Association, p. 292-293. URL : http://hdl.handle.net/2027/spo.bbp2372.1995.088 [consulté le 15/11/2020]

Vickery Lindsay (2016), « Hybrid real/mimetic sound works », in Richard Hoadley, Dominique Fober et Chris Nash (dir.), Proceedings of the Second International Conference on Technologies for Music Notation and Representation, Cambridge, Anglia Ruskin University, p. 19-24.

Vickery Lindsay (2018), « Some approaches to representing sound with colour and shape », in Sandeep Bhagwati et Jean Bresson (dir.), Proceedings of the Fourth International Conference on Technologies for Music Notation and Representation, 24-26 mai, Montréal, Université Concordia, p. 165-173.

Whittall Arnold (1999), Jonathan Harvey, Londres, Faber, Paris, Institut de recherche et coordination acoustique/musique, coll. « Compositeurs d’aujourd’hui ».

Zagorac Slavko et Alessandrini Patricia (2018), « ZScore: a distributed system for integrated mixed music composition and performance », in Sandeep Bhagwati et Jean Bresson (dir.), Proceedings of the Fourth International Conference on Technologies for Music Notation and Representation, 24-26 mai, Montréal, Université Concordia, p. 62-70.

Notes

1 La documentation de la célèbre analyse d’un son de cloche est consultable ici : http://brahms.ircam.fr/analyses/Mortuos/ [consulté le 15/11/2020]

2 Comme, par exemple, la pièce Das Hoheslied, In memoriam Jean-Claude Risset 3.

3 Comme, par exemple, dans la pièce du même nom : https://youtu.be/8R4Twc1A7Ks [consulté le 15/11/2020]

4 http://www.tenor-conference.org/ [consulté le 15/11/2020]

5 Study no. 8 de Ryan Ross Smith est un bon exemple de cette pratique : https://youtu.be/QeBwSYbHcbQ?t=471 [consulté le 15/11/2020]

6 Server-side JavaScript : https://nodejs.org/en/ [consulté le 15/11/2020]

7 bach est une librairie de composition assistée en temps réel pour Max/MSP.

8 La génération de ces partitions vidéo peut tout aussi bien s’effectuer avec un éditeur de partions, comme MuseScore, Finale, Sibelius, etc.

9 Rama Gottfried décrit Symbolist comme un programme de design graphique destiné à contrôler des éléments de notation musicale depuis Max/MSP.

10 L’objet bach.roll, éditeur en notation proportionnelle, est l’équivalent de l’objet chordseq dans OpenMusic.

11 Soit l’équivalent de l’objet voice dans OpenMusic.

12 Cette limitation graphique peut cependant être contournée en ajustant les paramètres de la duration line (incurvation et épaisseur du trait). L’utilisation de couleurs est également facilement accessible à l’aide des slots.

13 Une courte démo est disponible ici : https://youtu.be/s4qS2khwkT0 [consulté le 15/11/2020]

14 Une captation de la création est disponible ici : https://youtu.be/hQtyu1dcCaI [consulté le 15/11/2020]

15 https://youtu.be/ZrLgbBw4xfU [consulté le 15/11/2020]

16 https://youtu.be/zxnznD0Gzo0, la manipulation du dispositif de réalité virtuelle est visible à cet instant : https://youtu.be/zxnznD0Gzo0?t=553 (9 min 13 s) [consultés le 15/11/2020]

17 Voir Vortex Temporum (interprété par l’ensemble Ictus) : https://youtu.be/JFvrYy6EeWE [consulté le 15/11/2020]

18 Avec un casque Aryzon, par exemple, ou encore Microsoft HoloLens.

19 Les lunettes VuFine dupliquent simplement l’écran d’un téléphone (https://store.vufine.com/). Les lunettes Epson BT 350 disposent d’un système Android embarqué (https://youtu.be/eMAGRHEReyw, consultés le 15/11/2020).

20 Chaque partie instrumentale/vocale de la pièce And the Sea a été disponible à l’adresse suivante http://www.smartvox.eu/ et pouvait ainsi être accessible simultanément depuis, par exemple, un iPad pour la flûte, des tablettes Android pour le piano et le violoncelle et un smartphone pour la chanteuse. La bande-annonce de la pièce est disponible ici : https://youtu.be/prcXUbhd-ZY [consultés le 15/11/2020]

21 Le groupe américain de « computer network music » The Hub, formé en 1986, a fortement contribué à l’épanouissement du genre.

22 Traduction de l’auteur.

23 On peut observer trois avatars produire du son ensemble vers la fin de l’extrait suivant : https://vimeo.com/264626943 [consulté le 15/11/2020]

24 https://youtu.be/SyFdR2HiF00 [consulté le 15/11/2020]

25 SmartVox a été utilisé par Richard Baker, pour les répétitions et les performances de To See The Invisible, un opéra d’Emily Howard, à Aldeburgh en 2018 (au Snape Maltings Concert Hall) https://snapemaltings.co.uk/concerts- history/aldeburgh-festival-2018/to-see-the-invisible/ [consulté le 15/11/2020]

26 SmartVox est open source et téléchargeable sur GitHub : https://github.com/belljonathan50/SmartVox0.1 [consulté le 15/11/2020]

27 Le terme est attribué à Lindsay Vickery (Vickery, 2016).

28 Une démonstration du paramètre de liquéfaction est disponible au lien suivant : https://youtu.be/2kdIaqAhUGs [consulté le 15/11/2020]

29 Une captation est disponible à l’adresse suivante : https://youtu.be/ET_OBgFWx04 [consulté le 15/11/2020]

30 Un passage rythmique dans In memoriam Jean-Claude Risset 1 met ce phénomène en évidence : https://youtu.be/hQtyu1dcCaI?t=349 [consulté le 15/11/2020]

31 Une captation est disponible à l’adresse suivante : https://youtu.be/7GpArQa6mQ4 [consulté le 15/11/2020]

32 Voir https://youtu.be/7GpArQa6mQ4?t=25 pour une démonstration [consulté le 15/11/2020]

33 https://www.prism.cnrs.fr/ [consulté le 15/11/2020]