L’espace entourant – l’espace personnel

Quelques concepts spatiaux dans mes œuvres

Hans Tutschku octobre 2014

octobre 2014DOI : https://dx.doi.org/10.56698/rfim.370

Notes de la rédaction

Pour mieux visualiser certaines images, cliquez dessus pour les agrandir.

Notes de l'auteur

Pour des questions, n’hésitez pas à me contacter. Il y a quelques éléments supplémentaires sur ces pièces sur le site http://www.tutschku.com

Texte intégral

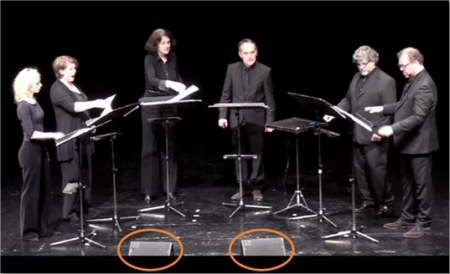

Introduction

1Je présente dans ce texte quelques expériences personnelles, en rapport avec le sujet de ce numéro. Depuis 1982, j’ai utilisé l’espace sonore dans des configurations très diverses, allant des compositions mixtes aux installations sonores, en passant par des pièces pour 24 haut-parleurs et pour la Wave-Field-Synthesis. Ce texte présente quelques exemples, avec des questionnements, sur les besoins artistiques et leurs implémentations techniques et compositionnelles.

2Je vais commencer par un rapide survol de mon parcours musical et technologique.

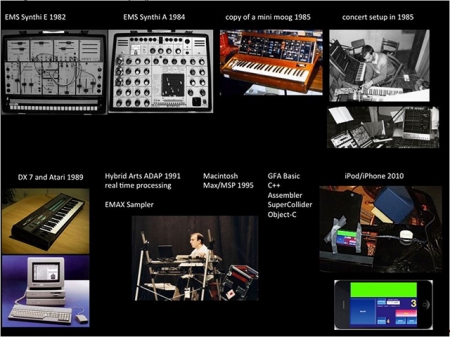

Figure 1. Survol historique

3J’ai commencé en 1982 à pratiquer les technologies analogiques avec un petit synthétiseur, le « Synthi-E ». Ensuite, un grand changement s’est produit pour moi avec l’arrivée de mon premier ordinateur en 1989, avec lequel l’aspect de la programmation est entré dans ma vie.

4Très vite, quand j’ai eu mon premier DX7, je me suis rendu compte que tout ce que je faisais avec cet instrument ne me plaisait pas. Tout ce que je voyais avec l’ordinateur ne me plaisait pas non plus. J’ai donc appris un certain nombre de langages, comme le Basic, le C etc., pour petit à petit me forger mes propres outils. C’était assez intéressant, surtout au début des années 1990, quand j’ai programmé un environnement de traitement en temps réel avec mon Atari. Le programme tournait sans l’utilisation de l’écran. L’ordinateur démarrait avec une disquette et un ensemble de fonctions était contrôlable par les touches du clavier. C’est à ce moment-là que l’ordinateur est devenu une espèce d’instrument parce qu’on n’était plus fixé à l’écran. C’était quelques années avant que Max/MSP ne soit disponible. Comme je joue dans « L’Ensemble de musique intuitive de Weimar » depuis 1982, avec lequel on fait beaucoup d’improvisation, on produit une musique dans laquelle la communication avec les autres musiciens sur scène joue un grand rôle. Quand on est trop fixé sur son écran, on perd une partie de sa concentration et on n’est plus tellement connecté avec les autres sur le plan musical.

5Depuis quelques années, comme les outils sont devenus de plus en plus petits, je me suis plongé un peu dans la programmation de l’iPhone, l’iPod, et l’iPad et je les ai utilisés à présent dans cinq compositions.

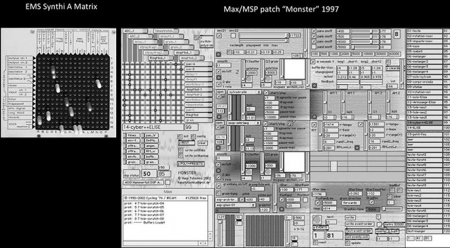

6J’ai appris, surtout avec les synthétiseurs analogiques, que tous les signaux pouvaient être utilisés en tant que signal sonore, mais aussi en tant que signal de contrôle. La matrice du Synthi-A (figure 2, à gauche) était mon inspiration quand j’ai commencé à fabriquer mes propres outils dans Max/MSP, comme on voit dans la figure à droite. La matrice permettait de nouveau d’utiliser le signal des microphones pour contrôler les oscillateurs ou l’amplitude des microphones pour déclencher des sons, c’est-à-dire n’importe quel signal pouvait devenir une source d’information pour la transformation en temps réel.

Figure 2. Matrices (à gauche Synthi-A, à droite patch Max/MSP)

7Je vais maintenant survoler trois pièces, à propos de leur implémentation technologique, mais aussi de leur relation avec l’espace.

1. L’espace intime, l’espace personnel

1. 1. Entwurzelt (2012)

8Entwurzelt est une composition pour six chanteurs et électronique, et qui emploie l’iPod comme technologie. C’est la troisième de mes pièces utilisant cette technologie, et dans chaque pièce j’ai trouvé différents types de relations entre le dispositif et les musiciens.

Figure 3. Dispositif scénique pour Entwurzelt

9Ce que j’appelle l’espace intime est réalisé par une technologie très simple. L’iPod est joué par un des chanteurs et il y a deux haut-parleurs, placés juste devant les six chanteurs. Il n’y a pas d’autres haut-parleurs dans la salle. Tout le son passe par ces deux haut-parleurs qui sont inclinés de manière à ce que le son n’aille pas directement dans le public, mais plutôt vers le plafond. Donc ils servent aussi bien de retour pour les musiciens, qui l’entendent assez pour que cela fasse moniteur. Ainsi, j’obtiens un bon mélange entre les sons non amplifiés des chanteurs et les sons électroniques.

1. 1. 1. L’idée de la pièce

10La pièce cherche une expression sensible, dans un langage inconnu. La relation étroite entre les passages joués en direct et l’électronique crée un monde sonore nous incitant curieusement à la découverte de son sens. La composition n’est pas basée sur un texte. J’ai écrit un texte que j’ai ensuite démonté.

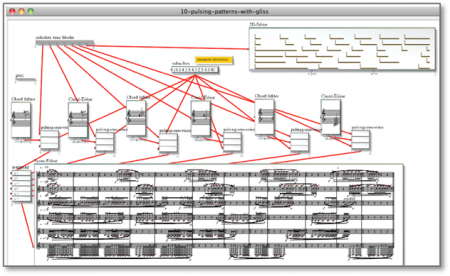

11D’abord, j’ai commencé à réfléchir à quelques idées formelles. Dans le schéma ci-dessous, on peut remarquer des groupes de matériaux pour les différents chanteurs. Une grande partie de la pièce repose sur la segmentation des différents matériaux, sur leur superposition, leur interruption, leur reprise, etc. Il y a des blocs entiers qui se retrouvent plus tard dans la pièce dans une forme variée. Les variations sont un principe de base de beaucoup de mes œuvres.

Figure 4. Esquisses pour la structure de la pièce et matériau harmonique

12La pièce est basée sur une série d’accords. Tout cela a été formalisé dans PWGL, une plateforme que j’utilise depuis plusieurs années. Dans les années 1990, j’utilisais PatchWork, puis OpenMusic. Maintenant je travaille avec PWGL. C’est la continuation de la version de PatchWork de Mikael Laurson et c’est un programme très puissant et très intéressant.

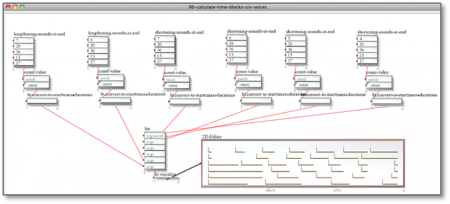

13Dans la figure suivante, on voit la segmentation du temps. Il y a des proportions de durées, et tendances. La première soprano chante de petits moments avec de longues pauses. Elle va chanter de plus en plus, pendant que les hommes vont chanter de moins en moins. J’utilise des procédés très simples et bien connus.

Figure 5. Les distributions temporelles des matériaux musicaux, séparés par des silences, pour les six voix

14Une fois que les processus temporels ont été établis, on a des cases de temps qui vont être remplies par le matériau musical.

Figure 6. Remplissage des blocs temporels avec le matériau musical

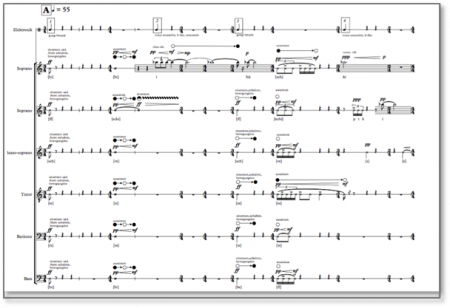

15Il n’est pas question de faire un cours sur la CAO, mais simplement de montrer quelques exemples. La figure suivante montre la partition finale. On voit très bien ces assemblages de différents moments d’activités alternant avec des moments de silence.

Figure 7. Extrait de la partition de Entwurzelt

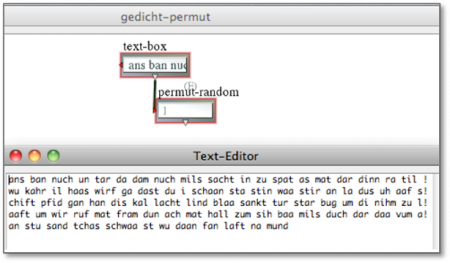

16Comme je l’indiquais précédemment, il n’y a pas de texte, mais seulement un parcours de syllabes. J’ai écrit un texte que j’ai placé dans PWGL et qui a subi un ensemble de permutations, de distorsions, de coupures etc. Au départ, c’étaient des petites phrases, écrites dans une multitude de langues, et à la fin on trouve un mélange de syllabes provenant de ces différentes langues et qui ont été ordonnées par leurs voyelles.

17Toute la pièce commence avec la voyelle « i ». On entend beaucoup de petits fragments, de syllabes qui contiennent un « i », mais qui proviennent de plein de langues.

Figure 8. Permutations du texte

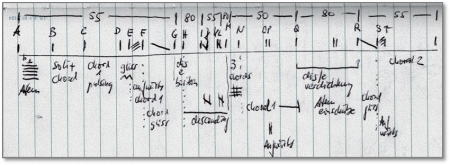

18La figure suivante donne la forme générale de la pièce. La pièce se base en gros sur trois tempos. Le tempo 55 est un peu plus lent que le battement du cœur. Le tempo 80 est un peu agité, et le troisième est encore plus lent, 50, qui est une sorte de repos.

19La composition a environ une dizaine de caractéristiques musicales qui vont se retrouver dans une sorte de puzzle : des petites pièces qui se retrouvent, qui se perdent, qui vont être éparpillées.

Figure 9. Forme générale de la pièce

1. 1. 2. La technologie

20Nous allons parler un peu de la technologie et de l’implémentation. La raison pour laquelle je travaille avec l’iPod, ce n’est pas parce que c’est à la mode. Pour moi, la question était toujours guidée par la situation des répétitions. Comme je l’ai indiqué précédemment, on passe toujours beaucoup de temps sur la fabrication de ces outils électroniques et on n’a pas assez de temps pour répéter avec les musiciens.

21Si on regarde cette situation du point de vue du musicien, c’est encore pire. Il apprend une partition comme une pièce purement instrumentale en étant conscient qu’il y a une partie qui manque, mais il n’a aucune manière de savoir comment elle va sonner. Il n’a pas les moyens techniques de s’installer un microphone, une carte son, un ordinateur avec le patch, etc. dans son espace de travail. Cette musique est souvent pratiquée comme une musique de chambre. Parfois même des ensembles se retrouvent dans cette situation. Très tard dans le processus, il y a quelqu’un qui arrive avec la technologie et on a peut-être deux répétitions, peut-être uniquement une seule, le jour du concert.

22J’ai pu observer que les musiciens se mettent dans ces cas dans un mode de protection, c’est-à-dire qu’ils ont appris quelque chose qui maintenant est perturbé par la partie électronique. On n’a pas donné aux musiciens l’occasion d’intégrer la partie électronique dans leur interprétation. Ils jouent avec l’électronique en disant : « vous faites cela, mais pas trop fort, car je veux jouer ce que je connais ». J’ai alors cherché une autre manière d’approcher la situation. Comme il y a des musiciens qui ont des iPad à la maison, j’ai composé des pièces où toute la partie électronique est dans l’appareil d’iOS. Ce n’est pas le contrôle d’un ordinateur à travers de OpenSoundControl, car toute la partie électronique est à l’intérieur de l’appareil. Les pièces utilisant ce dispositif permettent aux musiciens de répéter avec toute la partie électronique dès le départ.

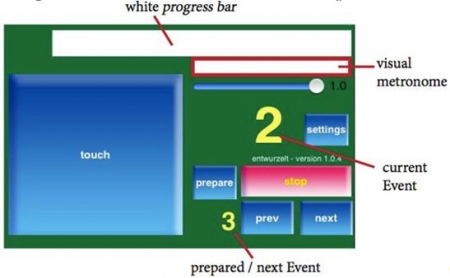

23L’interface est très simple, mais fonctionnelle. Pour Entwurzelt, l’électronique est divisée en quatre-vingts séquences. Dans la partition ci-dessous, on peut voir quelques moments où débutent les séquences électroniques. L’un des chanteurs de l’ensemble appuie sur un bouton pour les déclencher.

Figure 10. Le premier système de la partition indique les moments de démarrage des séquences électroniques

24La figure suivante représente l’interface détaillée que le musicien voit sur l’iPod. Il contient le gros bouton pour déclencher les séquences. Dans les répétitions, il faut aussi pouvoir les arrêter, aller en avant, en arrière, et on a un bouton pour quelques réglages. On voit un métronome, qu’on peut activer ou non, et il y a une barre blanche qui défile de gauche à droite et qui indique la durée précise de la séquence. Si les musiciens prennent un tempo plus rapide ou plus lent, la partie électronique et le métronome visuel seront resynchronisés au prochain déclenchement.

Figure 11. L’interface utilisateur sur l’iPod

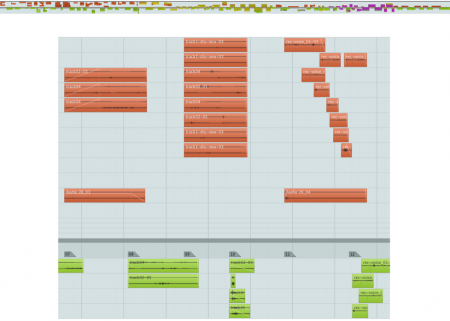

25La figure 12 montre l’assemblage des séquences dans Nuendo lors de la composition. Il y a toujours quelques secondes de chevauchement au début d’une nouvelle séquence. Dans le cas où les musiciens auraient chanté trop lentement, ils vont déclencher la séquence suivante un peu plus tard, mais la séquence précédente dure toujours un peu plus pour couvrir ces cas.

26Au déclenchement, l’application elle-même fait un fondu enchaîné vers le fichier son suivant pour que la partie électronique semble continue.

Figure 12. L’assemblage des séquences audio lors de leur composition

27Sur le lien suivant, vous pouvez écouter un extrait de quelques minutes de cette pièce, pour avoir une idée de l’écriture vocale ainsi que du mélange avec les sons électroniques. C’est un enregistrement avec le groupe Vocalsolisten Stuttgart du concert de la création.

1. 2. Still Air 1 (2013)

28Still Air 1 (2013) est la seconde pièce que je vais présenter. Elle reprend la même idée de l’interaction entre musicien et électronique, mais de façon encore plus limpide. Au lieu d’avoir six musiciens sur scène, il n’y en a qu’un. C’est une pièce pour clarinette basse et électronique, et cette fois-ci les deux petits haut-parleurs sont placés derrière le musicien de telle sorte que le son soit dirigé vers le plafond. Ils sont derrière le musicien, donc peu visible, et le son est produit pratiquement au même endroit que là où est le musicien. La pièce Entwurzelt était une pièce extrêmement virtuose. Dans cette nouvelle pièce je cherchais également une virtuosité, mais très différente. C’est une pièce très lente dans laquelle je demande au musicien de garder la tension, la phrase musicale, avec très peu d’activité, mais très souvent pour des longues durées. J’ai demandé parfois au musicien de jouer un multiphonique très faible, très doux, mais sans interruption pendant trente secondes. Cela crée une tension due à la quasi-impossibilité d’un contrôle fin sans respirer.

29Cette fois-ci, j’ai utilisé le microphone intégré de l’iPad, pas pour enregistrer parce que la qualité ne serait pas assez bonne, mais pour mesurer l’intensité du son du musicien. L’électronique est composée de deux couches. Les sons sont précomposés et l’intensité du jeu de l’instrument est utilisée pour contrôler la manière dont une des deux couches est reproduite. Cette couche joue en arrière-plan, mais on ne l’entend pas jusqu’à ce qu’on fasse un son dans le microphone de l’iPad. Donc, avec un crescendo du musicien, il y a aussi un crescendo du son préparé qui est émis. J’utilise également une légère transposition du son précomposé pour qu’il se mélange au mieux avec les sons multiphoniques de l’instrument.

30La seconde couche de l’électronique ne suit pas l’instrumentiste et est comparable à une bande traditionnelle. Elle me permet de produire des sons indépendants de la dynamique de la clarinette et également dans les moments de silence de l’instrument.

Figure 13. Utilisation du microphone intégré de l’iPad pour contrôler l’électronique

L’écran donne un retour visuel pour l’interprète sur les sections temporelles

31Dans la figure suivante, on peut remarquer que c’est presque la même interface que pour Entwurzelt. Dans la partition il n’y a pas de barres de mesure, il n’y a pas de métrique, le temps est exprimé en secondes. On a donc un compteur qui donne le temps à l’intérieur d’un événement. Le musicien n’appuie sur le bouton qu’une fois pour démarrer la pièce, et après, l’écran lui donne le feedback visuel pour savoir où il est, pour se resynchroniser sur le début du prochain événement.

32Tous les paramètres du suiveur d’enveloppe sont stockés dans une base de données, ce qui me permet de faire des changements de paramètres et de télécharger une nouvelle version de la base de données, sans avoir à créer une nouvelle version de l’application qui doit toujours être autorisée par le App Store. Ainsi je peux faire des modifications à l’intérieur de l’application et les télécharger directement dans l’iPad.

Figure 14. L’interface utilisateur de l’iPad et un aperçu de la banque de sons intégrée dans l’iPad

33Le schéma suivant représente le deuxième événement qui est joué pour une durée de 44 secondes. Il y a une alternance entre deux multiphoniques. C’est tout ce que le musicien a comme instructions. Il a donc une certaine responsabilité de création. Je lui demande de devenir « inventeur », pour rendre ce passage comme une phrase musicale satisfaisante.

Figure 15. L’événement n° 2 de la partition

34On peut écouter un extrait en cliquant sur le lien suivant. C’est une production de studio, avec la musicienne Rane Moore. L’exemple montre bien l’interaction entre le musicien et l’électronique.

35Un autre aspect qui m’a poussé dans cette démarche, concerne la programmation dans les concerts. Imaginons le projet d’un concert pour deux pianos. Les pianistes ont choisi une pièce pour deux pianos et électronique, et le reste du programme est uniquement instrumental. Ce projet peut poser un problème à l’organisateur. Il lui faut des haut-parleurs, une table de mixage, des microphones, un ordinateur, un ingénieur du son, etc., tout cela pour une seule pièce dans le programme. L’organisateur va plutôt dire : « et bien, peut-être qu’on va remplacer cette pièce par une autre pièce instrumentale ». Ou il va dire « on peut faire l’effort pour l’électronique, mais dans ce cas, jouez tout un programme avec piano et électronique », ce qui n’était pas l’idée des pianistes au départ. Les musiciens vont maintenant devoir intégrer d’autres pièces qu’ils ne connaissent pas aussi bien, ou qu’ils n’ont pas envie de jouer.

36En utilisant cette technologie réduite, je cherche également la possibilité d’intégrer ces pièces dans un programme complètement instrumental. Il n’y a pas de technicien son puisque c’est le musicien qui installe ses deux petits haut-parleurs et l’iPad ou l’iPod.

37Je ne veux pas dire que je vais composer pour iOS jusqu’à la fin de mes jours parce que c’est assez limité sur le plan compositionnel. Ça offre des avantages, mais ce n’est pas comparable au traitement sonore en temps réel qu’on peut réaliser avec PD ou Max/MSP. Mais l’exploration de cette plateforme m’a beaucoup appris sur la relation entre les musiciens et la technologie.

Figure 16. La partition du début de Still Air 1 (2013)

2. L’espace enveloppant

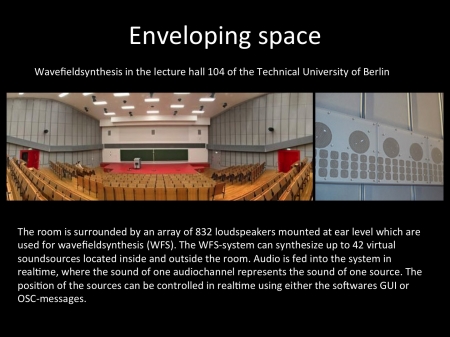

38Un autre aspect de mon travail, c’est le son dans l’espace, et je vais parler d’une pièce dans laquelle j’ai poussé cet aspect assez loin. J’ai travaillé avec la Wave-Field Synthesis. Il y a un système installé en permanence dans le Lecture Hall 104 à l’Université de Technologies de Berlin, une grande salle de 700 places, avec une grande bande de haut-parleurs installés tout autour de la salle. On peut voir ces panneaux à droite dans la figure suivante. On a en tout 832 canaux et 2400 haut-parleurs, mais qui ne sont pas contrôlés comme dans un acousmonium traditionnel dans lequel on pense qu’un haut-parleur est une voie. Le système calcule les positions pour les 42 sources possibles et les place ou les déplace à l’intérieur de l’espace. Il est possible de donner l’impression que les sons proviennent de l’extérieur de l’espace, ou qu’ils se localisent à l’intérieur du volume de la salle.

Figure 17. Le système WFS du Lecture Hall 104 de l’Université de Technologies de Berlin

39En 1998, a eu lieu à Berlin durant le festival Inventionen une rencontre avec le GRM qui est venu avec son acousmonium. Il y avait aussi une installation avec des haut-parleurs MM4 de Meyer, placés en cercles sur de grands pieds au-dessus du public.

Figure 18. Festival Inventionen 2008, Music for more than one loudspeaker

40À cette occasion, on m’avait demandé de créer une pièce pour ce système. Je l’ai appelée Zwei Räume (deux espaces) parce que je pensais justement à cette opposition entre le monde du WFS qui donne un champ sonore assez vaste, mais pas très spécifique sur l’emplacement du son, et l’utilisation des haut-parleurs discrets, que l’on connaît très bien avec l’acousmonium et avec le cercle des haut-parleurs placés au-dessus.

41Je ne vais pas parler du concert, parce que c’est une occasion qui ne s’est présentée qu’une fois, qui fut une expérience très intéressante mais pas très facile à reproduire par la suite. La question porte plutôt sur les outils de studio qu’on a à disposition pour composer pour plusieurs haut-parleurs. Comment peut-on concevoir des espaces dans une pièce multipiste qui va au-delà de huit haut-parleurs ?

Figure 19. Zwei Räume (deux espaces), composition électroacoustique pour 24 canaux

42On connaît beaucoup de technologies pour donner l’impression de l’emplacement d’une source, mais aussi du mouvement d’une source. Très souvent, on simule le déplacement d’une source monophonique à l’intérieur d’un espace virtuel.

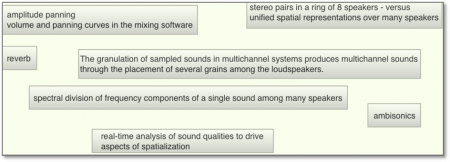

Figure 20. Quelques exemples de techniques de spatialisation

43Depuis quelques années, j’utilise le système Ambisonics, mais mon but ici n’est pas de recréer des espaces enregistrés avec Ambisonics. J’utilise le moteur de restitution pour faire quelque chose d’un peu inhabituel. Cette recherche a commencé il y a 6-7 ans quand j’ai comparé plusieurs méthodes de spatialisation. J’ai observé que chaque type de matériau sonore marche mieux avec un certain type de spatialisation. Il y en a qui fonctionnent bien avec certains matériaux sonores quand c’est rythmé, d’autres quand c’est une structure granuleuse, quand il y a des trames, quand il y a des impacts, etc. Si on veut des emplacements très précis, on a un peu de mal avec l’Ambisonics, parce que tous les haut-parleurs sont impliqués constamment dans la restitution du champ sonore.

44Mais ce qui m’a dérangé dans tout cela, c’est l’idée d’avoir une source monophonique que l’on essaye de déplacer dans l’espace. J’ai commencé à réfléchir à d’autres modèles, à d’autres possibilités.

45L’image d’un train se prête bien pour mieux expliquer ma démarche. Si on est proche de la voie et que le train arrive, on n’entend pas uniquement une source : elle est composée de plusieurs voitures. Quand le train passe, venant de la droite, on entend la voiture proche la plus forte, mais également les voitures qui s’éloignent vers la gauche et les autres qui s’approchent par la droite.

46Je compose d’abord huit variations de mon son par filtrages, transpositions, granulations, etc. Par la suite, je crée une chaîne spatiale en utilisant un modèle physique de contrôle. C’est cette chaîne spatiale qui se déplace à l’intérieur de l’espace. Chaque boule du modèle représente la localisation d’une de mes huit variations.

47Un exemple de l’interface du patch Max/MSP est disponible dans une vidéo sur le lien suivant.

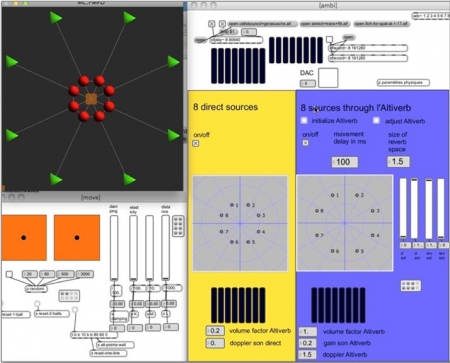

48Cette vidéo simule les interactions possibles avec le patch. On voit deux espaces Ambisonics distincts guidés par le modèle physique situé à gauche. J’utilise la librairie PMPD de Cyrille Henry qui a été écrite d’abord pour PD puis convertie pour Max/MSP. C’est un moteur qui calcule des modèles physiques de contrôle, sans produire du son.

Figure 21. Contrôle de la spatialisation par modèles physiques

49Les huit boules sont reliées avec des ressorts les unes à la suite des autres et forment une chaîne. On peut les tirer avec le carré orange ce qui va créer un écartement spatial des huit sources. Si on imagine que cette chaîne de huit boules fait une trajectoire à travers l’espace, l’auditeur entend les huit variations du même son passer. Cela donne un champ spatial de la source, qui est plus grand et des typologies de mouvements plus intéressants que le déplacement d’une source mono.

50À droite, ce sont les deux moteurs Ambisonics. Dans le rectangle jaune se trouvent les sons directs, qui sortent du sfplay. L’espace dans le rectangle bleu représente la réverbération. L’idée vient d’une expérience sonore que j’ai faite un jour. J’étais assis dans un grand couloir et il y avait une femme en talons qui passait « clac-clac-clac-clac ».

51Elle était déjà passée quand je me suis rendu compte qu’il y avait une deuxième vague de sons qui passaient et c’était la réverbération dans le couloir. Je suis sorti du bâtiment avec l’image de cette femme qui marchait avec ses talons suivis par un halo de réverbération. J’extrapole cela dans ce logiciel. Le mouvement de la réverbération peut être retardé. Je ne retarde pas le son de la réverbération, uniquement le mouvement. Normalement, je mets un retard de 200ms ou 250ms. En même temps, je change l’échelle en le mettant plus grand. La réverbération va parcourir des espaces plus grands que le son direct. Tout cela est scientifiquement faux, ce qui ne me pose aucun problème, parce que je ne suis pas un scientifique. Empiriquement, en écoutant dans le studio, cela me donne des espaces et des mouvements qui pour moi sont plus convaincants.

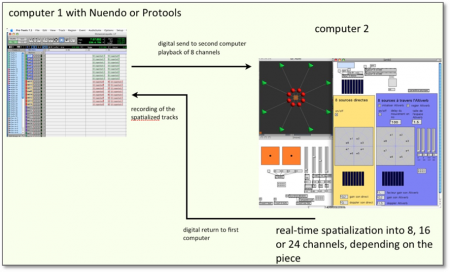

52Ma manière de travailler est la suivante (cf. figure ci-dessous). Je travaille avec deux ordinateurs. J’ai d’un côté Nuendo qui joue les huit sons de base. Ils entrent numériquement dans la carte son du deuxième ordinateur. Sur celui-ci je joue la spatialisation en écoutant les résultats et je renvoie le signal dans le premier ordinateur qui enregistre la version spatialisée directement sur les huit pistes suivantes. Si c’est une pièce en seize pistes, je divise le signal direct et le signal réverbéré. Au lieu de les mélanger, j’envoie seize pistes de retour dans Nuendo et j’enregistre les sons réverbérés et directs d’une manière indépendante pour que je puisse les restituer sur des haut-parleurs distincts. Dans la composition Zwei Räume j’utilise souvent les haut-parleurs placés dans la salle pour les sons directs et le système de Wave-Field-Synthesis pour restituer l’espace réverbéré.

Figure 22. Utilisation de sons octophoniques comme matériaux de départ

53Pour chaque matériau je compose donc d’abord huit variations. Celle-ci seront spatialisées et produisent 8 ou 16 nouvelles pistes.

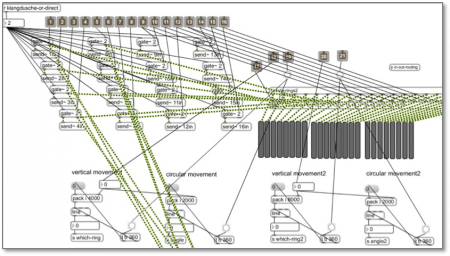

54J’utilise également d’autres patches Max/MSP, qui ne font pas uniquement la spatialisation, mais appliquent en même temps un traitement sonore multipiste.

Figure 23. Traitement et spatialisation dans un même processus

55Dans la figure 24, on voit la version 24 voies.

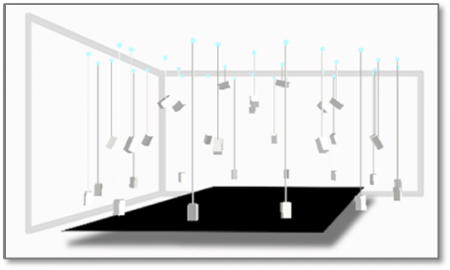

56L’espace est composé de trois cercles de 8 haut-parleurs : un à la hauteur de l’oreille, un plus petit et plus haut et ensuite un troisième, encore plus petit et plus haut pour faire une sorte de coupole. Composer pour une telle configuration de haut-parleurs pose la difficulté de trouver une manière de contrôler le mouvement qui fait une trajectoire à l’intérieur de cette coupole. J’ai donc modifié le patch précédent. Un mouvement des huit sources traversant l’espace en deux dimensions sur l’écran de l’ordinateur produit en effet une trajectoire montante et redescend dans la coupole.

Figure 24. Version 24 voies

57J’espère que ces exemples donnent un aperçu de l’utilisation compositionnelle et technologique dans quelques compositions récentes.

Bibliographie

Vidéos

Entwurzelt, par le Vocalsolisten Stuttgart, 2012 : http://www.tutschku.com/content/works-entwurzelt.fr.php

Still Air 1, avec Rane Moore, 2013 : http://www.tutschku.com/content/works-StillAir1.en.php

Un exemple de l’interface du patch Max/MSP : http://www.tutschku.com/content/works-physicalmodelambisonics-video.en.php